Text: Michael Seemann / Datenauswertung: Michael Kreil (DataScience&Stories des Tagesspiegels)

[Dokument als PDF laden.]

[English Version]

Einleitung

Das Internet war für mich immer der Traum der Freiheit. Damit meine ich nicht nur die Freiheit der Kommunikation und der Information, sondern auch die Hoffnung auf eine neue Freiheit der sozialen Beziehungen. Soziale Beziehungen sind, trotz aller sozialer Mobilität der modernen Gesellschaft, auch heute noch etwas sehr Unfreies. Vom Kindergarten über die Schule, den Verein bis zum Unternehmen durchlaufen wir ständig Organisationsformen, die uns fremdbestimmt gruppieren, sortieren und somit entindividualisieren. Von der Hasen- und Igel-Gruppe bis zur Staatsbürgerschaft ist die Gesellschaft als Gruppenspiel organisiert und unsere Mitspieler dürfen wir uns nur selten aussuchen. Und dann heißt es: „Finde dich ein, ordne dich unter, sei ein Teil von uns.“

Das Internet erschien mir als Ausweg. Wenn sich jeder Mensch mit jedem anderen Menschen direkt in Beziehung setzen kann – so mein naiv-utopische Gedanke – dann braucht es keine vergemeinschaftenden Strukturen mehr. Auf einmal können Individuen sich auf Augenhöhe begegnen und sich selbst organisieren. Gemeinschaften entstünden auf einmal als Resultat individueller Beziehungen, statt umgekehrt. Im Idealfall gäbe es überhaupt keine Strukturen mehr, die über die individuell-selbstbestimmten Beziehungsnetzwerke jedes Einzelnen hinausgingen.1

Spätestens die Wahl Donald Trumps war es, die mich unsanft aus meinen Hoffnungen riss. Die Alt-Right-Bewegung – ein Zusammenschluss aus rechtsradikalen Hipstern und den nihilistischen Auswüchsen der Nerdkultur – verbuchte für sich, Trump ins Weiße Haus „geshitpostet“ zu haben. Gemeint ist die massive Flankierung des Wahlkampfes mit Grassroots-Kampagnen im Internet mittels Memes. Und auch wenn man argumentieren kann, dass ihr Einfluss auf die Wahl längst nicht so groß war, wie die Trolle es gerne darstellen: die Meme-Kampagne zeigte auf jeden Fall die enorme Kraft digitaler Agitation.

Doch es war nicht die diskursive Macht internetgetriebener Kampagnen, die mich so nachhaltig erschreckte. Die ist seit dem arabischen Frühling und Occupy Wallstreet ein alter Hut. Es war die vollkommene Loslösung von Fakten und Realität, die sich in der Alt-Right entfaltete und die – angetrieben durch die vielen Lügen Trumps und seiner offiziellen Kampagne – einer unheimlichen Parallelrealität zur Macht verhalf. Die Verschwörungstheoretiker und Spinner haben ihre Nischen im Internet verlassen und regieren nun die Welt.

Auf der Suche nach einer Erklärung für dieses Phänomen bin ich immer wieder auf den Zusammenhang von Identität und Wahrheit gestoßen. Die Menschen, die daran glauben, dass Hillary und Bill Clinton eine Reihe von Menschen ermorden ließen und die Demokratische Partei einen Kindesmissbrauchs-Ring im Keller einer Pizzafiliale in Washington betreibt, sind nicht einfach dumm oder unaufgeklärt. Sie verbreiten diese Nachricht, weil sie damit die Zugehörigkeit zu ihrer Gruppe signalisieren. David Roberts hat dieses Phänomen treffend als „Tribale Epistemologie“ bezeichnet und definiert es folgendermaßen:

„Eine Information wird nicht anhand von Kriterien wie wissenschaftliche Standards der Beweisführung oder gar der Anschlussfähigkeit an das allgemeine Weltverständnis beurteilt, sondern einzig und allein danach, ob sie den Werten und Zielen des Stammes entspricht. ‘Gut für unsere Seite’ und ‘wahr’ beginnen eins zu werden.“ 2

Auch im deutschsprachigen Internet haben sich neue soziale Strukturen entwickelt, die eine vergleichbare Stammesdynamik aufweisen. Die Mitglieder eines solchen „digitalen Stammes“ kennen sich selten persönlich, wohnen nicht in derselben Stadt, wissen oft sogar nicht einmal die Namen der anderen. Und doch sind sie online eng vernetzt, kommunizieren stetig untereinander und haben sich gegenüber der Restöffentlichkeit ideologisch wie auch vernetzungstechnisch abgespalten. Verbunden fühlen sie sich vor allem durch ein gemeinsames Thema und die Ablehnung der von ihnen als falsch empfundenen Debatte darüber im „Mainstream“.

Es ist deswegen vielleicht kein Zufall, dass man auf einen solchen „digitalen Stamm“ stößt, wenn man eigentlich die Verbreitung von Fake News untersuchen will. Fake News sind nicht, wie es oft angenommen wurde, die Produkte sinisterer Manipulatoren, die damit die öffentliche Meinung in eine bestimmte Richtung lenken wollen. Sie sind vielmehr das Futter für bestätigungshungrige Stämme. Die Nachfrage macht hier das Angebot, nicht andersrum.

Seit der vorliegenden Untersuchung bin ich überzeugt: „Digitaler Tribalismus“ bildet den Kern des Erfolges von Bewegungen wie Pegida und AfD, wie auch der Alt-Right und den antiliberalen Kräften, die letztes Jahr weltweit Erfolge feierten.

Für die vorliegende Untersuchung haben wir über viele Monate hinweg Hunderttausende von Tweets ausgewertet, Forschungsfrage an Forschungsfrage gereiht, meterweise Literatur gewälzt und eine ganze Reihe von Theorien entwickelt und ausprobiert. Ausgehend von Twitterdaten über Fake News sind wir auf das Phänomen des digitalen Tribalismus gestoßen, dem wir von dort weiter auf den Grund gegangen sind.3 In dieser Untersuchung werden wir zeigen, wie sich Fake News links und rechts des politischen Spektrums tatsächlich verbreiten und wie soziale Strukturbildung im Netz zu hermetischen Gruppen führen kann. Wir werden auch zeigen, was die Theorie der „Filterbubble“ erklären kann und was nicht. Wir werden eine völlig neue Perspektive auf die rechte Internetszene bieten, die vielleicht dabei hilft zu verstehen, wie sich Hass im Netz findet, verhärtet, wächst und organisiert. Wir werden aber nicht alle Fragen beantworten können, die sich entlang dieses Phänomens stellen, deswegen soll dieser Essay vor allem ein Aufruf zu weiterer, interdisziplinärer Forschung sein.

Blaue Wolke, roter Knoten

Anfang März dieses Jahres war auf Twitter große Aufregung. Die Bundesregierung habe klammheimlich eine Reisewarnung für Schweden herausgegeben, so hieß es in verschiedenen Tweets. Die Bundesregierung und die Medien würden das aber verschweigen, denn es ginge um erhöhte Terrorgefahr. Viele waren sich einig: Das soll aus politischen Gründen totgeschwiegen werden.

Zum Hintergrund: Schweden hat, wie Deutschland, einen großen Anteil syrischer Flüchtlinge aufgenommen. In ausländischen Medien, vor allem rechtsgerichteten, wird seitdem so getan, als würde dort Bürgerkrieg herrschen. Die Meldung von der totgeschwiegenen Terrorwarnung passte also prima ins Bild.

Zum Beweis wird in den Tweets tatsächlich auf die Website des Auswärtigen Amtes zu den Reisehinweisen nach Schweden verwiesen.4 Ging man Anfang März dem Link nach, fand man tatsächlich eine Terrorwarnstufe. Sie stand auf 3 (erhöht) und ist bis heute auf diesem Niveau. Zudem fand sich der Hinweis der letzten Website-Änderung: 1. März 2017.

Was dort Anfang März noch nicht steht, ist, dass diese Terrorwarnstufe von den schwedischen Behörden schon länger herausgegeben wird und dass die letzte Änderung keine Erhöhung, sondern eine Herabstufung von 4 (hoch) auf 3 (erhöht) war.

Das Auswärtige Amt reagierte nach einiger Zeit auf die Gerüchte und stellte die Sachlage auf ihrer Website richtig. Auch einige Medien griffen den Fall und die Richtigstellung auf. Doch der Schaden war da. Die falsche Nachricht hatte bereits tausende Menschen erreicht, die sich in ihrer Meinung bestätigt fühlen durften: Dass erstens die Zustände in Schweden bürgerkriegsähnlich seien und dass zweitens die Medien und die Politik die Probleme totschwiegen.

Was Anfang März geschah, passt gut in das Raster der sogenannten „Fake News“. Also Nachrichten, die quasi aus der Luft gegriffen sind, sich aber durch ihre vermeintliche Brisanz viral im Netz verbreiten.5 Vor allem im rechten Spektrum gehören sie heute zur Normalität im Netz.6

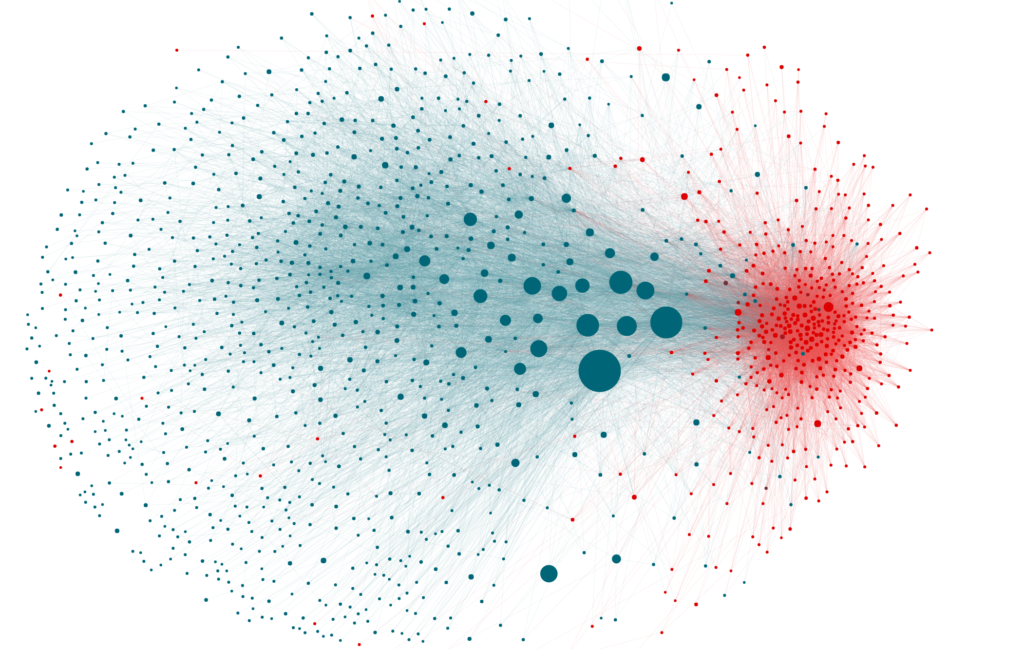

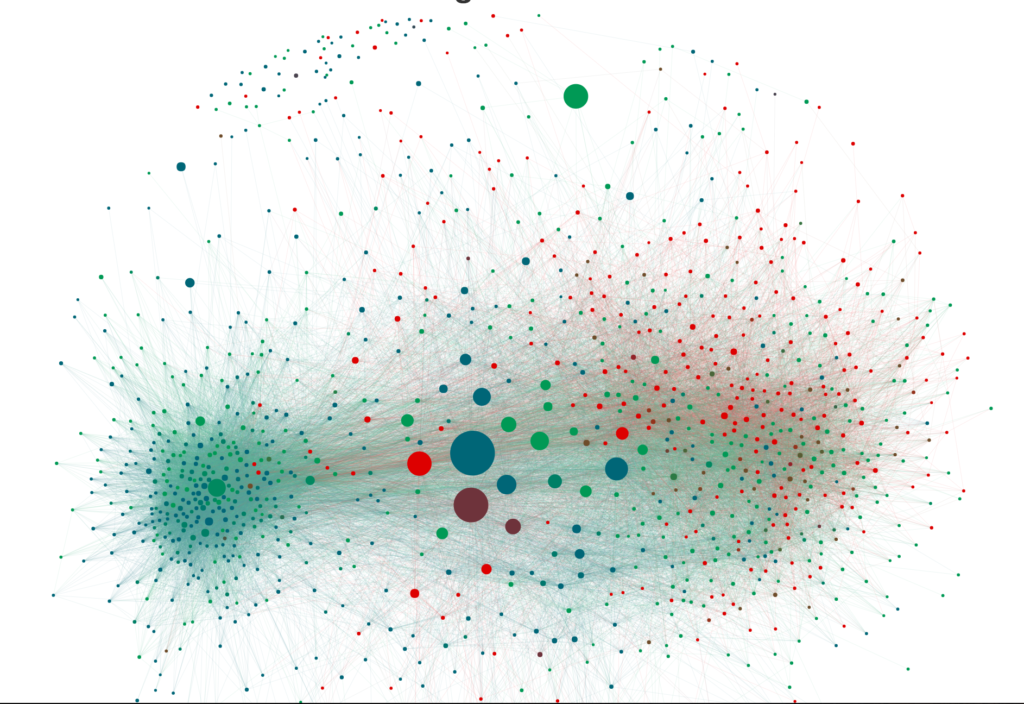

Der Datenjournalist Michael Kreil schaute sich den Fall genauer an. Er wollte wissen, wie sich Fake News verbreiten und ob die Richtigstellungen ein geeignetes Gegenmittel sind. Er holte sich die Twitterdaten von allen Accounts, die zu dem Thema etwas geschrieben hatten, und markierte die Tweets mit Fake News rot und die Tweets mit Richtigstellungen blau. Dann ordnete er die Accounts zueinander so an, dass sie Aufschluss über die Vernetzungsdichte geben. Wenn zwei Accounts sich gegenseitig folgen und/oder den selben Leuten folgen oder von den selben Leuten gefolgt werden, werden sie nah beieinander dargestellt. Je näher Punkte einander sind, desto enger sind diese vernetzt. Die Größe der Punkte entspricht der Anzahl von Followern, die der Account erreicht.

Das Ergebnis ist erstaunlich: Statt eines großen Netzwerks sehen wir zwei fast komplett voneinander getrennte Netzwerke. Diese Trennung wird einerseits durch die Farben deutlich und gleichzeitig durch die Anordnung der Accounts zueinander. Auf der linken Seite sehen wir eine recht weit gestreute, blaue Wolke, die sich nach außen hin zerfastert. Dazu sehen wir recht dicht zueinander stehend mehrere große blaue Punkte. Das sind die Massenmedien wie Spiegel Online, Zeit Online, Tagesschau und so weiter. Die blaue Wolke sind alle Accounts, die die Richtigstellungen veröffentlicht oder retweetet haben.

Auf der rechten Seite sehen wir einen stärker konzentrierten, dafür etwas kleineren, roten, nach außen ausfransenden Knoten. Es ist ein Knoten aus vielen Punkten, die sehr eng beieinander liegen. Das sind die Fake-News-Verbreiter. Sie sind nicht nur sehr eng vernetzt, sondern auch vernetzungstechnisch fast komplett abgeschnitten von der großen, blauen Wolke.

Das Entscheidende ist die deutliche Trennung der roten von der blauen Gruppe. Es findet praktisch gar kein Austausch statt. Jede Gruppe verharrt bei der von ihr verbreiteten Wahrheit.

“Das ist eine Filterblase”, mit diesen Worten und der Grafik kam Michael zu mir und fragte, ob ich bei der Untersuchung mitmachen wolle. Michael Kreil ist Teil des DataScience&Story-Teams des Tagesspiegels und gehört zur Avantgarde des deutschen Datenjournalismus. Ich sagte zu, obwohl ich der Filterblasen-These gegenüber skeptisch war.

Auf den ersten Blick leuchtet die These ein. Eine Filterblase ist, wenn man auf seinen Social-Media-Accounts nur noch Ansichten auf die Welt angezeigt bekommt, die mit den eigenen konform gehen. Eli Pariser – derjenige, der den Begriff 2011 geprägt hat – bezog das vor allem auf die Algorithmen von Google und Facebook, die uns unsere Suchergebnisse oder unser Newsfeed personalisiert vorsortieren.7 Diese Algorithmen versuchen einzuschätzen, was uns gefällt, und geben uns so eine gefilterte Realität wieder. Doch auch auf Twitter gibt es Filterblasen. Hier kann jeder sein eigenes kleines Mediennetzwerk zusammenstellen, das heißt jeder kann Accounts folgen, deren Sicht auf die Welt ihn interessiert. Was dabei oft hinten runterfällt ist die abweichende Meinung, die unliebsame Weltsicht, oder einfach die fremdartige Perspektive.

In der Debatte um Fake News ist die Filterblasen-Theorie deswegen immer wieder eine schlüssige Erklärung. Wenn wir nur noch Sichtweisen auf die Welt dargelegt bekommen, die uns in den Kram passen, erreichen uns deren Widerlegungen vielleicht gar nicht mehr. Filterblasen werden zur Echokammer, aus der immer nur herausschallt, was wir hineinrufen.

Verifikation

Bevor wir die Filterblasen-These untersuchten, versuchten wir allerdings zunächst die Ergebnisse anhand eines zweiten Fake-News-Beispiels zu reproduzieren. Und das fanden wir diesmal in den Massenmedien.

Am 5. Februar berichtete die BILD-Zeitung von einem angeblichen „Sexmob“ von rund 900 Flüchtlingen, die in der Silvesternacht im Frankfurter Stadtteil Freßgass Menschen belästigt haben sollen. Die Nachricht war deswegen brisant, weil es in der Silvesternacht des vorherigen Jahres in Köln zu ähnlichen Ausschreitungen gekommen ist. Die Nachricht der BILD machte schnell die Runde, vor allem weil sie den Eindruck erweckte, die Frankfurter Polizei habe den Vorfall über einen Monat lang verschwiegen.

Tatsächlich hatte ein Bildjournalist sich die Geschichte von einem AfD-nahen Kneipenwirt aufschwatzen lassen und BILD druckte sie, ohne sie ausreichend geprüft zu haben. Die Polizei konnte die Angaben nicht bestätigen und auch sonst ließ sich keine zweite Quelle für den Vorfall finden. Andere Medien griffen die Geschichte damals trotzdem auf, oft allerdings mit einer gewissen Vorsicht. Im Verlauf des Skandals wurde klar, dass der Kneipenwirt sich alles nur ausgedacht hatte und die BILD-Zeitung musste sich öffentlich entschuldigen.

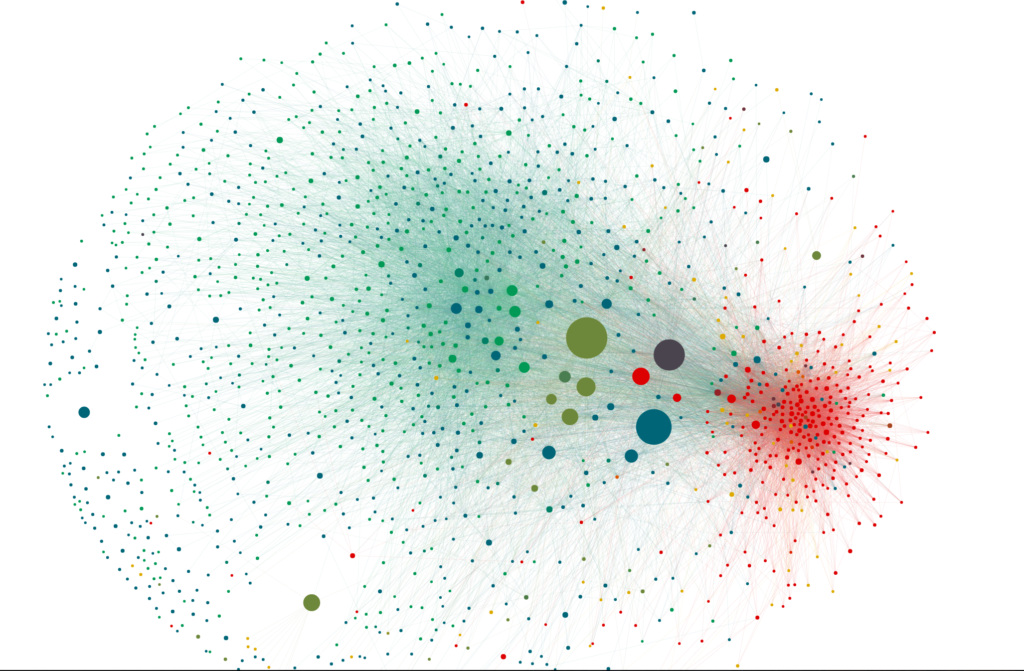

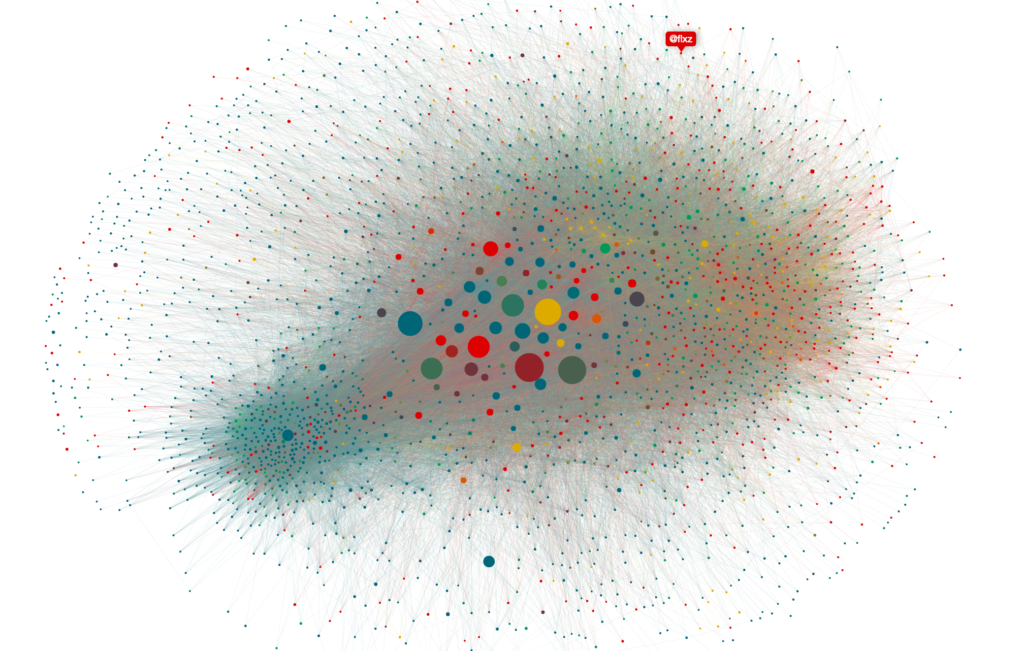

Dieses Mal mussten wir bei der Auswertung etwas anders vorgehen, weil die Debatte auf Twitter diesmal vielschichtiger war und sich viele Berichte nicht eindeutig einer der beiden Kategorien „Fake News“ oder „Richtigstellung“ zuordnen ließen. Diesmal brauchten wir noch eine dritte Kategorie dazwischen. Wir recherchierten alle Artikel zum Thema, sammelten sie in einer Tabelle und markierten, ob sie tendenziell die Falschmeldung weiterverbreiteten (rot), oder sie nur distanziert und unschlüssig weitergaben (gelb). Phrasen wie „Laut Berichten der BILD-Zeitung …“ und Hinweise darauf, dass die Polizei den Fall nicht bestätigen kann, reichten uns für das „unschlüssig“-Label aus. Natürlich suchten wir auch wieder die Artikel raus, die die Fake News widerlegten (blau). Wir vergaben auch noch eine vierte Kategorie: Meta. Im Anschluss an die Fehlleistung der BILD-Zeitung gab es eine ausführliche Debatte darum, dass ein umstrittenes, aber durchaus etabliertes Medium der Auslöser einer großen Fake-News-Kampagne werden konnte. Diese Metadebatten-Artikel färbten wir grün.8

Trotz der Vorsichtsmaßnahmen wird auf den ersten Blick klar, dass sich hier die Ergebnisse unserer ersten Auswertungen reproduziert hatten. Die Richtigstellung zerstäubt sich zusammen mit der Metadebatte als grün-blaue Wolke, die nur hier und da von gelben Sprenklern der Unschlüssigkeit aufgehellt wird. Vor allem aber hebt sich auch hier der rote Fake-News-Cluster deutlich vom Rest des Feldes ab – wieder farblich und vernetzungstechnisch. Unsere Fake-News-Blase ist offensichtlich ein stabiles, reproduzierbares Phänomen.

Die Filterblase

Immer noch stand die Theorie im Raum, wir hätten es mit der Manifestation einer Filterblase zu tun. Ich war skeptisch. Die Existenz einer Filterblase ist in unseren Beispielen jedenfalls nicht belegt: Die Theorie der Filterblase macht Aussagen darüber, wer welche Nachrichten zu Gesicht bekommt. Unsere Grafik veranschaulicht aber nur, wer welche Nachricht sendet. Um also einer Filterblase nachzuweisen, müssten wir untersuchen, wer welche Nachricht zu lesen bekommt und wer welche nicht.

Aber auch diese Information steckt in den Twitterdaten und lässt sich entsprechend abfragen. Wir können für einen beliebigen Twitter-Account nachvollziehen, wem er folgt. In einem zweiten Schritt können wir uns von den verfolgten Accounts die Tweets ausgeben lassen. Wenn wir die Tweets von allen verfolgten Accounts haben, können wir die Timeline des ursprünglichen Accounts rekonstruiert. So können wir letztendlich in die Filterblase des Accounts gucken und nachvollziehen, was er sieht. Im dritten Schritt können wir überprüfen, ob eine bestimmte Information seine Filterblase erreicht hat, odere nicht.

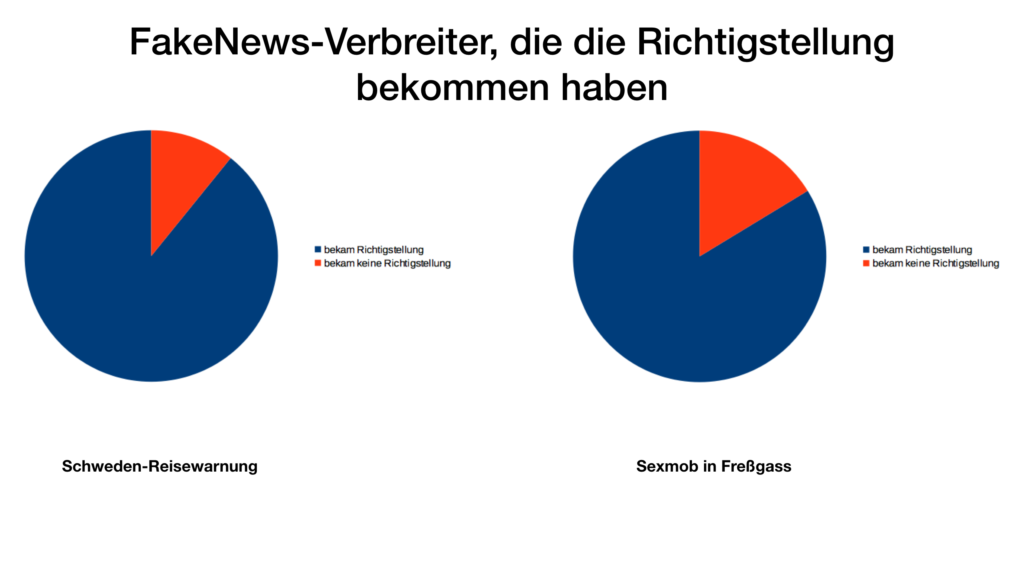

Wir besorgten uns also alle Timelines der Accounts, die die Fake News der Reisewarnung für Schweden verbreitet haben und guckten nach, ob sich dort Verweise auf die Richtigstellung finden. Das Ergebnis überrascht: Fast alle Fake-News-Verbreiter der angeblichen Reisewarnung – ganze 89,2 % – haben die Richtigstellung in ihrer Timeline gehabt. Wir machen den Test auch für die Freßgass-Meldung. Hier sind es 83,7 % der Fake-News-Verbreiter, die zumindest technisch von der Gegendarstellung erreicht wurden.

Die Ergebnisse werfen die Filterblasen-Theorie über den Haufen. Ganz offensichtlich sind es keine technischen Gründe, die diese Accounts einseitig nur die Fake News verbreiten lassen. Die Filterblase der Fake-News-Verbreiter ist zumindest alles andere als dicht.

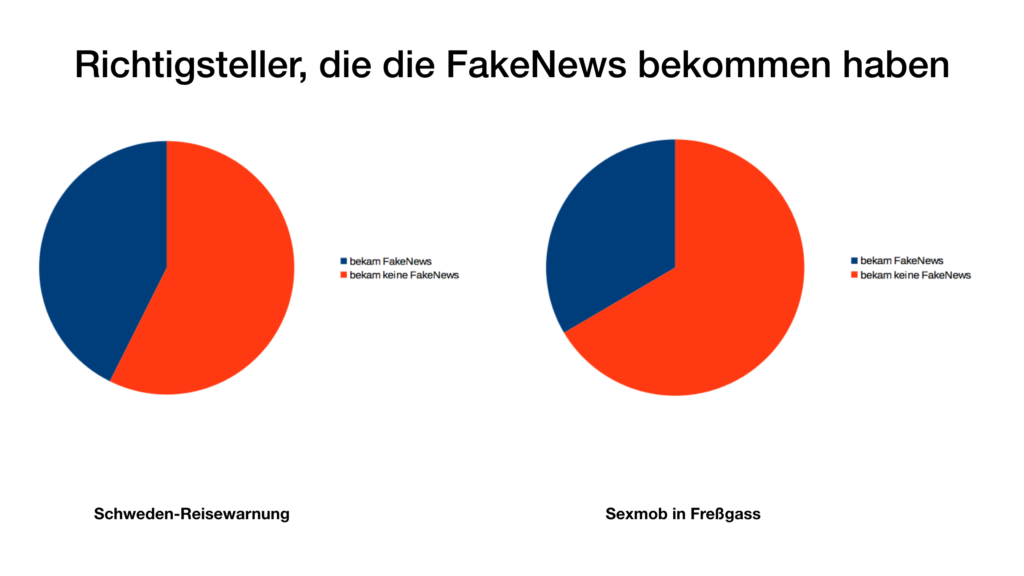

Ohne viel zu erwarten machen wir den Gegentest: Wie sieht es bei den Richtigstellern aus, was haben sie in der Timeline? Haben sie die originale Fake News überhaupt mitbekommen, die sie so heroisch bekämpfen? Wir laden uns ihre Timelines und gucken in ihre Filterblasen. Und wieder ein Ergebnis, das uns erstaunt: Gerade mal 43 % der Richtigsteller haben von der originalen Schweden-Fake-News mitbekommen. Bei der Freßgass-Geschichte ist der Wert mit 33 % sogar noch geringer. Diese Ergebnisse deuten tatsächlich auf eine Filterblase hin, allerdings in die andere Richtung.

Es gibt also kaum Filterblasen-Effekte von Fake-News-Verbreitern gegenüber den Richtigstellern, wohl aber andersrum.9 Die Ergebnisse scheinen den gesamten Filterblasen-Diskurs umzudrehen. Nein, Filterblasen sind in unseren beiden Beispielen nicht an der ungehinderten Verbreitung von Fake News schuld. Das genaue Gegenteil ist der Fall. In unseren beiden Beispielen können wir zeigen, dass die Filterblasen gegen die Verbreitung von Fake News wirken. Sie „schützen“ aber nicht vor Richtigstellungen.

Kognitive Dissonanz

Wir haben es hier nicht mit einem technischen Phänomen zu tun. Der Grund, warum die Menschen im roten Knoten Fake News verbreiten ist nicht ihre filterbedingte Uninformiertheit oder eine technisch verzerrte Sicht auf die Welt. Weil sie von der Richtigstellung erreicht wird, diese aber nicht weiterverbreitet, müssen wir davon ausgehen, dass die Gruppe die Fake News verbreitet, völlig unabhängig davon, ob die Informationen wahr sind oder nicht – einfach weil sie es so will.

Das Phänomen gleicht vielmehr dem, was Leon Festinger bereits in den 50er Jahren untersuchte, und dem er den Namen „Kognitive Dissonanz“ gab.10 Festinger trat damals im Selbstversuch einer Sekte bei, die den Weltuntergang beschwor und immer wieder genau datierte. Festinger wollte wissen, warum die Sektenmitglieder trotz der andauernd falschen Prophezeiungen nicht aufhörten, an die Untergangslehre zu glauben. Seiner Theorie nach neigen Menschen dazu, Ereignisse verzerrt wahrzunehmen, je nachdem wie gut sie zum eigenen Weltbild passen. Widerspricht ein Ereignis unserem Weltbild, entsteht die besagte “Kognitive Dissonanz”: die Unvereinbarkeit von Realität und Vorstellung. Weil so eine Kognitive Dissonanz als sehr unangenehm empfunden wird, versuchen Menschen intuitiv, sie zu vermeiden. Das führt zu einem Verhalten, das Psychologen auch den Bestätigungsfehler (englisch: „Confirmation Bias“) nennen. Es werden nur noch Informationen wahr- und ernst genommen, die in das eigene Weltbild passen. Der Rest wird ausgeblendet, relativiert oder schlicht geleugnet.

Die Theorie der Kognitiven Dissonanz würde also vorhersagen, dass wir es beim roten Knoten mit einer Gruppe von Menschen zu tun haben, deren spezifisches Weltbild durch die Fake News bestätigt wird.

Um diese Hypothese zu testen, haben wir uns die letzten paar Hundert Tweets der Twitterer herausgezogen – sowohl von den Fake-News-Verbreitern, als auch von den Richtigstellern – und haben Worthäufigkeiten verglichen. Wenn die Theorie richtig ist, müsste sich zeigen lassen, dass die Fake-News-Gruppe ein gemeinsames, homogenes Weltbild hat.

Dazu haben wir insgesamt 380.000 Tweets aus Twitter geholt und den Textkorpus statistisch ausgewertet. Dabei haben wir die relative Häufigkeit von Worten in beiden Gruppen abgeglichen und ein Ranking der Worte erstellt. Ganz oben stehen Worte, die in der einen Gruppe viel, aber in der anderen Gruppe wenig vorkommen.11

Wenn man bedeutungsarme Begriffe wie „via“, „die“ und „the“, sowie häufig erwähnte Twitteraccounts rausnimmt, kommt bei der Fake-News-Gruppe eine sehr aussagekräftige Liste prominenter Worte heraus. Ihre 16 wichtigsten Begriffe sind in absteigender Reihenfolge: Islam, Deutschland, Migranten, Merkel, Maas, Politik, Freiheitskampf, Flüchtlinge, SPD, NetzDG, NPD, Antifa, Zensur, PEGIDA, Syrer, Asylbewerber.

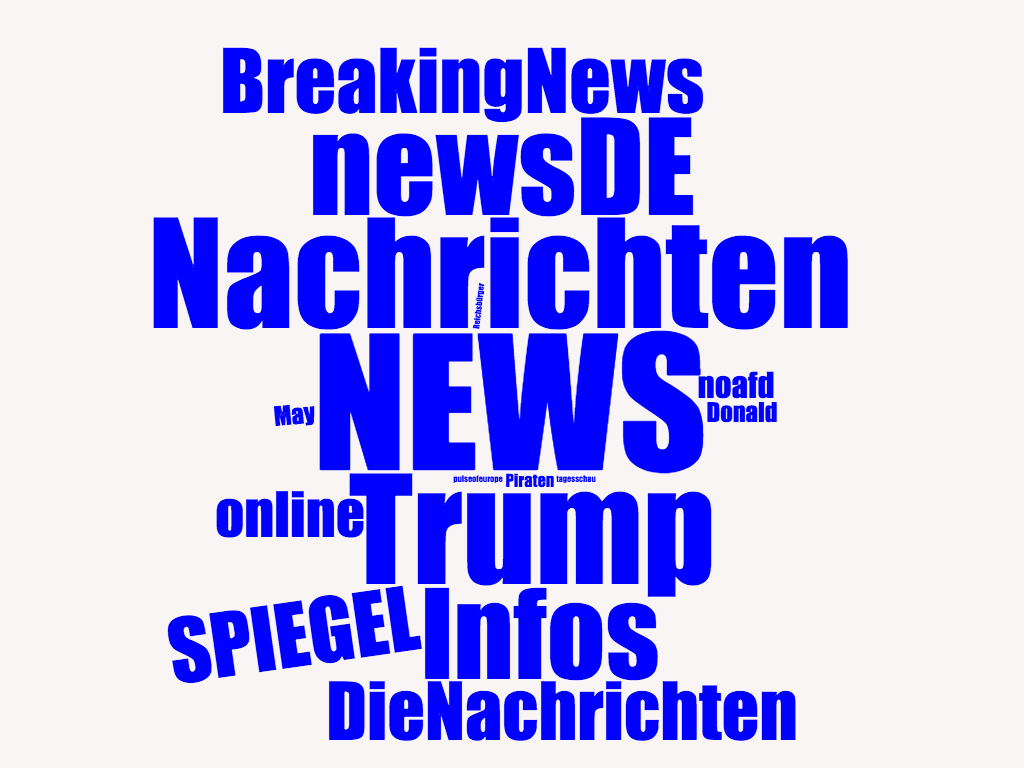

(Die Wortgröße entspricht der relativen Häufigkeit der Begriffe.)

Eine gewisse thematische Homogenität ist bereits auf den ersten Blick erkennbar. Allerdings ergeben sich bei näherem Hinsehen zwei Geschichten, die in dieser Gruppe erzählt werden:

Die erste Geschichte handelt von Migration: Islam, Migranten, Flüchtlinge, PEGIDA, Syrer, höchstwahrscheinlich auch „Merkel“ und „Deutschland“ sind recht eindeutig der Erzählung über die Flüchtlingskrise – oder allgemein dem Thema Migration – zuzuordnen. Bei der manuellen Durchsicht der Tweets geht es immer wieder um die Gefahren des Islams und um einzelne Kriminalfälle durch Menschen mit Migrationshintergrund, speziell Flüchtlinge.

Eine zweite, nicht ganz so starke Erzählung betrifft das Selbstverständnis dieser Gruppe: nämlich Opfer politischer Verfolgung zu sein. „Maas“, „Freiheitskampf“, „SPD“, „NetzDG“, „Antifa“ und „Zensur“ weisen deutlich auf diese Opfererzählung hin. So geht es konkret viel um die Einführung des Netzwerkdurchsetzungsgesetzes (kurz: NetzDG) durch den Justizminister Heiko Maas (SPD), das vor allem von rechter Seite als politischer Angriff auf sie und ihre Überzeugungen verstanden wird.

Wie massiv die thematische Homogenität der Fake-News-Verbreiter ist, merkt man vor allem, wenn man sie mit den wichtigsten Begriffen der Richtigsteller vergleicht: NEWS, Nachrichten, Trump, newsDE, Infos, BreakingNews, SPIEGEL, DieNachrichten, online, noafd, May, Donald, Piraten, tagesschau, pulseofeurope, Reichsbürger.

Zunächst fällt auf, dass die wichtigsten Begriffe der Richtigsteller gar nicht politisch vereinnahmt sind. Es geht vielmehr um Medienmarken und um Nachrichtenberichterstattung im Allgemeinen: NEWS, Nachrichten, newsDe, Infos, BreakingNews, SPIEGEL, DieNachrichten, tagesschau, Wochenblatt. Neun der 16 Begriffe haben diesen allgemeinen Nachrichtenbezug.

Aus den restlichen Begriffen lässt sich allerdings eine leichte Tendenz ablesen, sich wiederum mit dem politisch rechten Spektrum zu beschäftigen. Donald Trump ist ein so großes Thema, dass sowohl sein Vor- als auch Nachname in den Top 16 auftauchen. Dazu scheinen die Hashtags „noafd“ und das proeuropäische Netzwerk „pulseofeurope“ recht populär zu sein und auch die „Reichsbürger“ werden thematisiert.

Aus der Worthäufigkeitsanalyse lassen sich also drei Schlüsse ziehen:

- Die Fake-News-Gruppe ist thematisch wesentlich fokussierter und politisch homogener als die Gruppe der Richtigsteller.

- Die Fake-News-Gruppe ist vor allem auf die negativ empfundene Seite von Migration und Flüchtlingskrise fokussiert. Zudem fühlen sie sich politisch verfolgt.

- Die Richtigsteller haben keine einheitliche politische Agenda, allerdings ein leicht gesteigertes Interesse für rechte Strömungen.

All dies scheint die Hypothese der Kognitiven Dissonanz zu bestätigen. Tatsächlich handelt es sich bei beiden Fake-News-Beispielen um Geschichten über Probleme mit Flüchtigen, also genau um das Kernthema der roten Gruppe. Das Vermeiden von Kognitiver Dissonanz könnte also das unkritische Teilen der Fake News sowie das Nichtteilen der Richtigstellung wider besseren Wissens erklären.

Digitaler Tribalismus

Beim Vergleich der zwei Gruppen in beiden Beispielen haben wir bereits drei wesentliche Unterscheidungsmerkmale festgestellt:

- Die Gruppe der Richtigsteller ist größer, weiter gestreut/wolkenartig und inkludiert die Massenmedien, während die Fake-News-Gruppe enger vernetzt, kleiner und konzentrierter wirkt.

- Die „Filterblase“ der Richtigsteller-Gruppe ist gegenüber Fake News wesentlich undurchlässiger als umgekehrt.

- Die Fake-News-Gruppe ist thematisch deutlich fokussierter als die Richtigsteller.

Kurz: Wir haben es hier also mit zwei völlig unterschiedlichen Arten von Gruppen zu tun. Wenn aber die Unterschiede auf Gruppenebene so deutlich hervortreten, wird eine individualpsychologische Erklärung nicht hinreichen. Es mag zwar sein, dass Kognitive Dissonanz beim einzelnen Fake-News-Verbreiter eine Rolle spielt, aber da wir sie als gruppenbezogene Auffälligkeiten beobachten, muss sie soziokulturelle Ursachen haben. Wir müssen hier noch tiefer graben.

Tatsächlich wird spätestens seit Jonathan Haidts Bestseller von 2012 „The Righteous Mind – Why Good People Are Divided by Politics and Religion“ moralische (und damit auch politische) Psychologie immer mehr im soziokulturellen Kontext gelesen. Haidt hatte anhand vieler Studien gezeigt, dass wir moralische und politische Entscheidungen einerseits intuitiv, statt rational entscheiden. Diese aber andererseits durch soziale und kulturelle Prägungen geleitet sind. Menschen sind von Natur aus mit einem moralischen Framework ausgestattet, aus dem sich die spezifischen Kulturen und Subkulturen dann eine zusammenhängende Ethik bauen. Kultur und Psychologie „make each other up“, wie es der Anthropologe und Psychologe Richard Shedem ausdrückt.12

Eine unserer moralisch-psychologischen Anlagen ist der Hang zum Tribalismus. Wir neigen dazu, unsere Stellung als Individuum immer in Beziehung zu konkreten Bezugsgruppen zu definieren. Unser moralisches Rüstzeug ist dafür ausgelegt, uns innerhalb von definierten Gruppen funktionieren zu lassen. Fühlen wir uns einer Gruppe zugehörig, zeigen wir intuitiv altruistisches und kooperatives Verhalten. Bezogen auf Fremdgruppen aber ist oft das Gegenteil der Fall. Wir sind misstrauisch, weniger empathisch und Fremdgruppen gegenüber sogar tendenziell feindlich eingestellt.

Haidt erklärt diese menschlichen Eigenschaften evolutionsbiologisch. Rational betrachtet wäre anzunehmen, dass rein egoistische Individuen den größten Überlebensvorteil hätten, Altruismus wäre da eher ein Hindernis.13 Ab einem bestimmten Punkt in der Werdung des Menschen habe sich der Selektionsprozess aber von der Ebene des Individuums auf die Ebene der Gruppe verschoben. Seit der Mensch den Weg zu intensiver Kooperation eingeschlagen hat (irgendwann zwischen 75.000 bis 50.000 v. Chr.) standen nicht mehr Individuen in evolutionärer Konkurrenz zueinander, sondern Stämme.14 Ab diesem Zeitpunkt setzte sich nicht mehr automatisch das egoistischste Individuum durch, sondern das kooperative.15 Man könnte auch sagen das „tribalistische“, denn es gehören eben nicht nur Altruismus und Kooperationsfähigkeit zu der tribalen Grundausstattung, sondern auch Abrenzungswillen, Gruppenegoismus sowie ein starkes Bedürfnis nach Zugehörigkeit und Identität. Eigenschaften, die häufig in Verhalten münden, das wir heute in unserer individualistischen Gesellschaft glaubten abgelegt zu haben, weil sie oft mit Krieg, Leid und Feindschaft in Verbindung gebracht werden.16

Nichtsdestotrotz gibt es seit längerem Versuche, Tribalismus als positiven Zukunftsentwurf zu etablieren. Bereits Anfang der 90er Jahre wurde von Michel Maffesoli der „Urban Tribalism“ ausgerufen.17 Dabei geht es nicht mehr um verwandtschaftsbasierte Stämme, sondern um mehr oder weniger selbst gewählte. Er bespricht dort vor allem „Mikrogruppen“, die wir heute wohl als Subkulturen bezeichnen würden. Vom Punk bis zur Aktivistengruppe empfinden Menschen das Bedürfnis, Teil von etwas Größerem zu sein und in Gemeinschaft und Identität aufzugehen. Dieser Trend wirke langfristig der Massengesellschaft entgegen, so Maffesoli.

Es geht aber auch radikaler. In seinem zivilisationskritischen Werk “Beyond Civilization” ruft der Autor Daniel Quinn dazu auf, zivilisatorische Errungenschaften und Institutionen komplett hinter sich zu lassen, um neue stammesähnliche Gemeinschaften zu gründen.18 Die Aktivist/innen von NEOTRIBES beziehen sich vor allem auf Quinn, wenn sie nach tribalen Auswegen aus der Massengesellschaft suchen, sehen aber vor allem das Internet als Ermöglichungstechnologie der neuen Stammeskulturen.19

2008 war es Seth Godin, der mit seinem Buch „Tribes“ darauf hinwies, wie gut sich das Internet eignet, eigene Stämme zu gründen.20 Sein Buch solle man dafür als Anleitung verstehen. Der zentrale Hinweis: Man müsse als Häretiker zum Mainstream auftreten, den wunden Punkt im etablierten Denken finden und sich ihm entgegenstellen. Mit etwas Glück fände man Anhänger der eigenen steilen These, die man dann über das Internet vernetzen und mobilisieren kann. Solche Stämme stiften Identität und entfesseln Energien bei ihren Anhängern, dass man mit ihnen zusammen die Welt verändern könne. Tatsächlich lassen sich viele der Ideen von Seth Godin gut auf heutige Gruppenphänomene im Internet übertragen, nicht zuletzt der Trump-Kampagne 2016.

Fassen wir zusammen: Digitale Stämme haben den verwandtschaftlichen mit einem umso stärkeren thematischen Fokus ausgetauscht. Das Thema ist Dreh- und Angelpunkt des Stammes und gleichzeitig das wesentlichste Abgrenzungsmerkmal zum „Mainstream“, demgegenüber er sich häretisch verhält. Dadurch wird eine starke Kohäsion und Homogenisierung nach innen erwirkt, aber vor allem eine starke Abgrenzung nach Außen. All das triggert die tribalistischen Grundlagen unseres Moralgefüges – es geht nur noch um „Die“ gegen „Uns“. Das spiegelt sich auch in den Erzählungen wider. AfD, Pegida und Co. sehen sich als Rebellen, die sich gegen den irrlichternden Mainstream wenden, der aus ihrer Sicht korrupt, bestenfalls ideologisch verblendet ist. Zudem fühlen sie sich politisch verfolgt und unterdrückt. Narrative wie das von der „Lügenpresse“ und den „Altparteien“ sind Werkzeuge, die Grenze zwischen dem eigenen und dem feindlichen Stamm zu markieren.21 Und es ist genau diese Abgrenzung, die wir anhand der Clusterbildung innerhalb der Netzwerkstrukturen einerseits und als thematische Fokussierung anhand von Wortstatistik andererseits empirisch aufzeigen können.

Gegencheck: Linke Fake News

Unsere These lautet also, dass wir es bei der roten Fake-News-Gruppe mit einem „digitalen Stamm“ zu tun haben und dass die Unterschiede zu der Richtigsteller-Gruppe aus ihren spezifisch tribalen Eigenschaften resultieren. Diese Eigenschaften sind: engere interne Vernetzung bei gleichzeitiger „Abspaltung“ vom Mainstream (Restnetzwerk), eine intensive thematische Fokussierung und daraus resultierend eine Anfälligkeit zur Verbreitung von Fake News, die in das thematische Raster fallen.

Unser Stamm ist offensichtlich rechtslastig: Seine Fokussierung auf die Flüchtlingsthematik spricht eine deutliche Sprache. Negative Flüchtlingsgeschichten werden nicht oder deutlich weniger hinterfragt und unkritisch verbreitet, selbst dann, wenn die Nachrichtenlage dünn und die Geschichten unplausibel sind. Teilweise werden die Geschichten sogar wider besseren Wissens verbreitet.

All das bedeutet allerdings nicht, dass es nicht auch ganz andere digitale Stämme im deutschsprachigen Twitter gibt oder geben kann. Unsere Entdeckung des Stammes mittels Fake News hat insofern einen eingebauten Bias. Die Fake-News-Ereignisse fungieren quasi als Blitzlicht, das eine Momentaufnahme eines Teils des Gesamtnetzwerks ermöglicht, aber eben nur eines begrenzten Teils. Mit Fake News von rechts entdeckt man rechte Stämme. Aber wenn unsere Theorie soweit richtig ist, könnte man linke Stämme endecken, indem man von links blitzt, das heißt linke Fake News untersucht. Jedenfalls sofern es welche gibt.

Um es vorweg zu sagen: Es war gar nicht leicht, linke Fake News zu finden. Jedenfalls wesentlich schwerer als rechte. Das ist auch deswegen interessant, weil es im US-Wahlkampf ganz ähnlich war.22

Ein Beispiel, auf das wir recht schnell stießen, ist der Fall Khaled, obwohl der Begriff Fake News hier nicht zu 100% passt.23

Am 13.01.2015 wurde der Flüchtling Khaled Idris aus Eritrea in Dresden erstochen aufgefunden. Das geschah während der Hochphase der Pegida-Demonstrationen, bei denen es zu verschiedenen anderen Gelegenheiten bereits zu gewaltsamen Ausschreitungen kam. Während also die Behörden noch ermittelten und sich mit Mutmaßungen zurückhielten, legten vor allem linke Medien und viele Twitternutzer/innen einen Zusammenhang des Mordes mit den Pegida-Demonstrationen nahe. Die Ermittlungsarbeit wurde skandalisiert („auf dem rechten Auge blind“) und der Tod Khaleds immer wieder vorschnell als rassistische Tat verurteilt. Durch die Ermittlungen der Polizei stellte sich schließlich heraus, dass Khaled von einem der Mitbewohner seiner Asylunterkunft erstochen worden war.

Wir gingen genauso vor, wie bei den ersten beiden Beispielen. Wir färbten also die Fake News (oder sagen wir: die falschen Mutmaßungen) rot und die Richtigstellungen blau. Grün ist wie zuletzt die Metadebatte, die gerade bei diesem Beispiel eine große Rolle spielte.

Die daraufhin entstandene Grafik ist auf den ersten Blick eine komplett andere und doch erinnern einige Strukturmerkmale auf eigentümliche Weise an unsere ersten beiden Grafiken – nur scheinen sie hier invertiert. So lässt sich die räumliche Aufteilung in zwei Cluster anhand ihrer Proportionen exakt wiedererkennen. Nur ist ihre örtliche und farbliche Verteilung eine völlig andere.

Wieder haben wir zwei Gruppen. Wieder haben wir die Wolke und den Knoten. Nur ist die Wolke dieses Mal auf der rechten, der Knoten auf der linken Seite.24 Wieder haben wir es mit einer kleineren, engeren und homogeneren Gruppe zu tun (was laut unserer Theorie wieder auf tribale Eigenschaften hinweist) und einer größeren, loseren Wolke, die wiederum die Massenmedien inkludiert. Auch hier ist die kleinere Gruppe wesentlich homogener in der Farbgebung. Doch anstatt Rot sind hier Grün und Blau dominant. Das Rot findet man dieses Mal in der großen Wolke, allerdings nicht als homogene oder auch nur dominante Farbe, sondern mehr als leichte Sprenkel – verteilt über die ganze Wolke, die eigentlich ebenfalls aus Richtigstellung (blau) und Metadebatte (grün) besteht.

Das sind Ergebnisse, mit denen wir nicht gerechnet haben. Zwar stand es durchaus in Frage, dass wir einen linken Stamm finden, aber eine so eindeutige Antwort hatten wir nicht erwartet. Wir fanden nicht nur keinen von Fake News getriebenen linken Stamm, sondern fanden wieder eine stammes-ähnliche Struktur, die in diesem Beispiel aber auf der Seite der Richtigsteller firmiert. In der Wolke finden wir zwar auch Fake-News-Verbreiter, aber es gibt keine Abspaltung, sondern eine wilde Vermischung von Fake-Newsern, Richtigstellern und Metadebattierern.

Um die Robustheit unserer Analyse zu stärken, untersuchen wir auch hier ein zweites Beispiel:

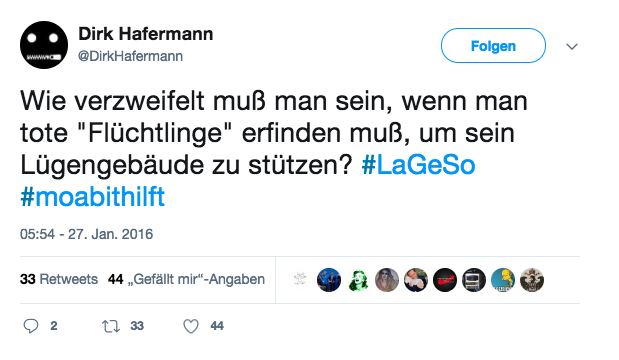

Am 27.1.2016 schreibt ein freiwilliger Helfer der Berliner Flüchtlings-Initiative „Moabit Hilft“ einen Facebook-Eintrag, in dem er von einem Flüchtling berichtet, der nach tagelangem Schlangestehen vor dem LAGeSo (Landesamt für Gesundheit und Soziales) zusammengebrochen und später im Krankenhaus verstorben sei. Die Nachricht verbreitete sich wie ein Lauffeuer, was auch daran lag, dass die Zustände am Berliner LAGeSo bereits seit dem Sommer 2015 allgemein als chaotisch galten. Viele Social-Media-Accounts griffen den Fall auf und skandalisierten ihn entsprechend. Auch Medien griffen die Ereignisse auf, einige zunächst recht unkritisch. Im Laufe der Zeit aber – als niemand den Toten bestätigen konnte und der Autor des ursprünglichen Facebook-Posts nicht auf Anfragen reagierte – wurde die Berichterstattung immer distanzierter. Noch im Laufe desselben Tages wurde der Nachricht auch offiziell von Polizeiseite widersprochen. In den folgenden Tagen stellte sich heraus, dass sich der Helfer die Geschichte wohl – anscheinend völlig überarbeitet und unter Alkoholeinfluss – ausgedacht hatte.

Wir gingen wie im Fall Khaled vor mit dem Unterschied, dass wir wieder die vierte Farbe Gelb verwenden, um die sich um Distanz Bemühten von den unkritischen Verbreitern der Fake News abzuheben.

Auch dieses Beispiel bestätigt die Erkenntnisse aus dem Fall Khaled. Wieder sind die Fake-News-Verbreiter weit verstreut, es lässt sich keine enger vernetzte Gruppe ausmachen. Auch in diesem Fall sticht eine abgespaltene Gruppe heraus, die besonders eifrig die Richtigstellung verbreitet. Das gibt unserer These Nahrung, dass es sich um dieselbe Gruppe handelt, wie die, die in den anderen Beispielen so anfällig für rechte Fake News ist: unser rechter, digitaler Stamm.

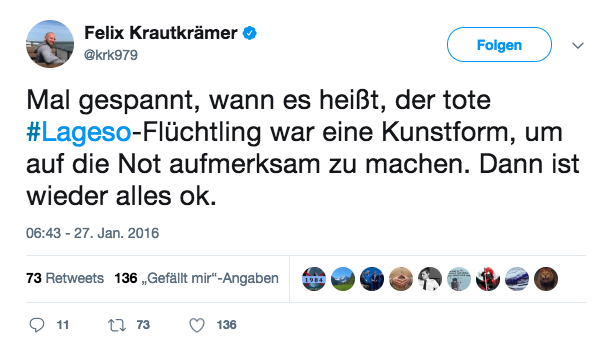

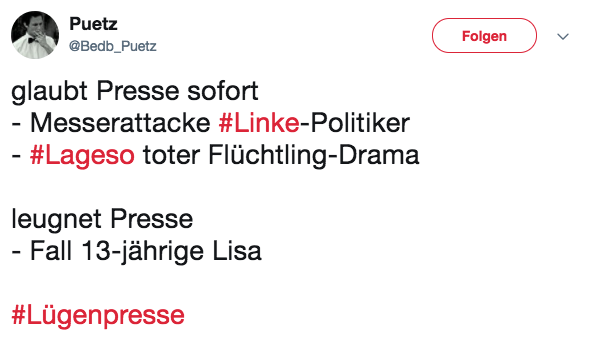

Um diese These zu untermauern sind wir „manuell“ durch den Tweet-Fundus gegangen und haben uns stichprobenartig einzelne Tweets aus der tribalen Gruppe angeschaut.

Um es vorsichtig auszudrücken: Hätten wir eine Farbe für Häme und Sarkasmus eingeführt, würde sich dieser Cluster noch deutlicher vom Rest abheben. Die Tweets sind inhaltlich zwar Richtigstellungen oder Metadebattenbeiträge, doch die Schadenfreude über die enthüllte Fake News ist unübersehbar. Hier ein paar Beispiele aus dem LaGeSo-Fall:

Noch dazu kommt in den Beiträgen das tiefe Misstrauen gegenüber den Massenmedien zum Vorschein, das bekanntermaßen im Begriff „Lügenpresse“ Ausdruck findet. In der Aufdeckung der Fake News wird wiederum ein tief verankerter Glauben an ein Narrativ dieses Stammes bedient: Dass die Medien die Wahrheit über die Flüchtlinge verschweigen und dass sie Geschichten über rassistische Gewalt erfinden oder übertreiben.

Als Erkenntnisse können wir festhalten:

- Anhand von linken Fake News zu Flüchtlingen lässt sich kein linkes Pendant des rechten Stammes nachweisen. Im Gegenteil zeigt sich, dass Verbreiter linker Fake News sehr gut im Mainstream integriert sind.

- Der Mainstream (die Wolke) selbst verhält sich bei linken Fake News ambivalent. Er twittert sowohl die Fake News, aber vor allem auch die Gegendarstellungen und die Metadebatte. Alles mischt sich in der großen bunten Wolke.25

- Der rechte Stamm ist hingegen als solcher auch bei linken Fake News erkennbar. Auch hier tritt er als abgespaltener Cluster und ungewöhnlich homogen in der Farbgebung hervor, nur hier eben auf der Seite der Richtigsteller. (Auch wenn die Richtigstellungen vor allem Verhöhnungen sind)

- Das bedeutet aber nicht, dass es A) keine linken Stämme gibt, die vielleicht bei anderen Themen, als der Flüchtlingskrise auffindbar sind. 26 Und B) dass es nicht noch eine Vielzahl anderer Stämme gibt, vielleicht mit gänzlich unpolitischen oder politisch nicht klar zuordenbaren Themen. Davon ist sogar auszugehen.

Tribale Epistemologie

Auch wenn einige Ergebnisse der linken Fake-News-Untersuchung überraschend sind, bestätigen und verfestigen sie unsere These des rechten Stammes um so mehr. Der rechte Stamm ist real und es ist wenig überraschend, dass er bei allen Nachrichten mitmischt, die etwas mit Flüchtlingen zu tun haben – ob nun auf der Fake-News-Seite oder nicht.27

Unser theoretisches Verständnis des „Tribalismus“ ist an dieser Stelle allerdings noch zu weit gefasst, um das beobachtete Phänomen in seiner Besonderheit zu fassen. Menschen tun sich gerne zusammen, Menschen grenzen sich gerne ab – soweit nichts neues. Im Grunde kann man alle losen oder festen Gemeinschaften eine tribalistische Grundlage unterstellen. Hacker, Piraten, Weird Twitter, die Netzgemeinde, Telekommunisten, Sifftwitter, 4chan, Prepper, Furrys, Cosplayer, Gamer, Bronies, etc. Alles „digitale Stämme“? Vielleicht. Aber wenn man das ohne genauere Prüfung behauptet, läuft der Begriff Gefahr, an Schärfe zu verlieren und wird den bisherigen Beobachtungen nicht mehr gerecht.28

Was unser Phänomen so besonders macht, ist dieser spezifische Bezug zur Realität, der sich zudem kongruent in der Netzwerkstruktur abbildet. Weltwahrnehmung und Gruppe – so scheint es – sind eins. Das ist das wesentliche Merkmal der „tribalen Epistemologie“.

Den Zusammenhang von Gruppenidentität und Wahrnehmungspsychologie, hat in den letzten Jahren vor allem Dan M. Kahan untersucht. Kahan und sein Team vom Cultural Cognition Project29 haben in verschiedenen experimentellen Studien gezeigt, wie sehr beispielsweise die politische Zugehörigkeit die Beurteilung von Argumenten und Fakten beeinflusst.

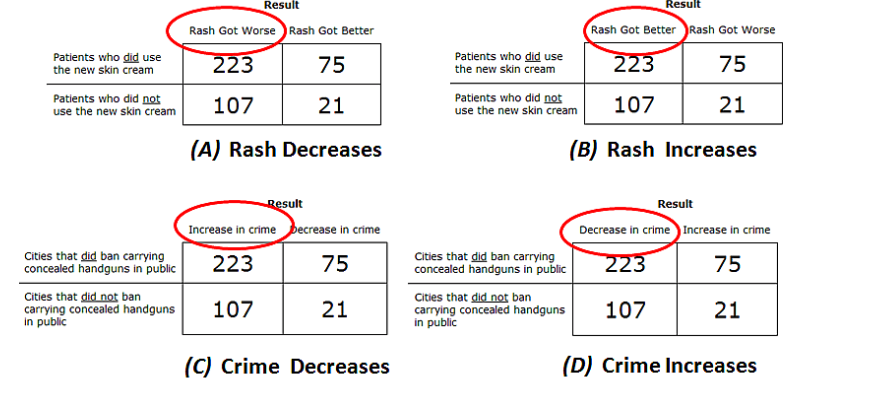

In einer Studie gab Kahan einer Gruppe von repräsentativ ausgesuchten Probanden vier Versionen einer Problemlösungsaufgabe.30 In zwei der Versionen ging es um Testergebnisse zu einer medizinischen Hautcreme und die Probanden sollten anhand der Daten einschätzen, ob die Creme hilfreich ist oder nicht. In der einen Version der Aufgabe zeigten die Daten, dass die Hautcreme eher schadet als nützt. In der anderen Version ging hervor, dass die Hautcreme die Situation verbessert. In den zwei anderen Aufgaben waren dieselben Daten aufgelistet, nur bezogen sie sich nicht auf die Wirksamkeit von Hautcremes, sondern auf die Wirksamkeit der politischen Maßnahme, das offene Tragen von Schusswaffen zu verbieten. Städte, die Schußwaffen gebannt hatten, hatten in der einen Version der Studie eine höhere, in der anderen Version eine niedrigere Kriminalitätsrate.

Alle Probanden wurden vor der Aufgabe unterschiedlichen Tests ausgesetzt; einerseits zu ihrer Zahlenkompetenz (numeracy) und andererseits zu ihrer politischen Einstellung. Es stellt sich heraus, dass die Zahlenkompetenz ein guter Vorhersagefaktor für den Lösungserfolg der Aufgabe ist, wenn die Zahlen in Bezug zur Wirksamkeit der Hautcreme interpretiert werden. Beziehen sich die Zahlen aber auf die Waffenbesitzregulierung, wiegt der Faktor der politischen Einstellung schwerer als der der Zahlenkompetenz. So weit, so wenig überraschend.

Das Überraschende ist nun, dass sich die Zahlenkompetenz bei polarisierenden Themen sogar negativ auswirkt. In der Waffenfrage war die ideologische Polarisierung bei Menschen umso deutlicher, je höher ihre Zahlenkompetenz war. Kahan interpretiert die Daten so, dass kognitive Kompetenzen in ideologischen Streitfällen nicht dafür eingesetzt werden, die eigene Einstellung mit der Welt der Fakten in Einklang zu bringen, sondern, dafür, die eigene Positionierung trotz Gegenbeweisen weiterhin zu rechtfertigen.

Kahan und seine Forscherkolleg/innen kommen zu einer verstörenden Schlussfolgerung: „Kultur schlägt Fakten“. Menschen sind intuitiv mehr daran interessiert ihren Identitätsrollen gerecht zu werden, als ein ungetrübtes Weltbild zu entwickeln und setzen ihre kognitiven Fähigkeiten deswegen für zweiteres ein. Kahan nennt dieses Phänomen „Identity protective cognition“, also „identitätsschützende Kognition“. Was der eigenen Identität gefährlich wird, wird mithilfe der eigenen intellektuellen Fähigkeiten einfach wegerklärt.31 Auffällig ist dieses Verhalten aber nur bei polarisierenden Themen, bzw. Themen, mit denen man sich sehr identifiziert – negativ wie positiv. Kahan konnte die Ergebnisse für verschiedene andere Themenbereiche bestätigen, zum Beispiel zur Frage des Klimawandels oder zur Frage nach Atommüll-Endlagerung.

Kahan hat dank seiner Forschung auch eine Theorie zu Fake News. Er glaubt nicht an die vorherrschende Erzählung, dass Fake News durch motivierte Kreise wie Wahlkampfteams, die russische Regierung oder enthusiastische Unterstützer/innen in die Öffentlichkeit eingeschleust werden, um diese zu manipulieren. Vielmehr glaubt er, dass es eine „motivierte Öffentlichkeit“ gibt, die einen Bedarf an Meldungen hat, die ihre Sichtweise bestätigen. Ein Bedarf, der größer ist als das Angebot an solchen Nachrichten.32 Fake News schließen gewissermaßen nur eine Marktlücke. Informationen dienen weniger als Wissensressourcen, denn als Identitätsressourcen – und da spielt es keine Rolle, ob sie wahr oder falsch sind.

Der rechte Stamm in unserer Untersuchung ist eine solche „motivierte Öffentlichkeit“. Zugehörigkeits- und Abgrenzungs-Signale spielen in ihrer Beurteilung von Fakten eine wesentlich größere Rolle, als Wahrhaftigkeit oder gar Plausibilität. Auch die Annahme, dass neue Informationen diese Gruppe in ihrem Denken umstimmen, oder entradikalisieren könnten, kann an dieser Stelle eine Absage erteilt werden. Richtigstellungen haben in so einem Klima zwar eine Chance wahrgenommen, aber nicht akzeptiert und erst recht nicht weiterverbreitet zu werden.

Tribale Institutionen in den USA

In seinem Text über die Tribale Epistemologie macht David Roberts eine weitere interessante Beobachtung, die auch gut auf die Situation in Deutschland übertragbar ist. Während die Massenmedien, die Wissenschaft und andere Institutionen sich als überparteilich präsentieren und verstehen, wird genau dieser Anspruch von der tribalen Rechten bestritten. Im Gegenteil wird von rechts unterstellt, dass die Institutionen eine liberale/linke Agenda fahren, dass sie mit dem politischen Establishment/Altparteien „unter einer Decke stecken“. Es wird folglich nicht nur die gegnerische Partei abgelehnt, sondern das gesamte politische, wissenschaftliche und mediale System wird als korrupt verworfen.33

Dass diese Verschwörungstheorien zwar falsch sind, aber einen gewissen wahren Kern haben, habe ich bereits anderswo ausgeführt.34 Tatsächlich ist es ja so, dass es in Medien, Politik und Wissenschaft einen gewissen liberalen Grundkonsens gibt, dem viele Bürger/innen skeptisch bis ablehnend gegenüberstehen.35

Statt aber die Institutionen reformieren zu wollen oder ihren Bias zu bekämpfen, verhelfen neue Kommunikationsstrukturen wie das Internet (aber nicht nur das Internet) dazu, kostengünstig alternative Medien und Institutionen zu etablieren. Genau das geschieht in den USA bereits seit den 90er Jahren kontinuierlich. Es hat sich dort eine Art rechte Parallelmedienlandschaft mit beachtlicher Reichweite und hohem Mobilisierungspotential gebildet. Das Entscheidende ist: da diese alternative Medienlandschaft den Anspruch der klassischen „Mainstreammedien“ zur Überparteilichkeit nicht anerkennt, versucht sie gar nicht erst diesem Ideal nachzueifern. Wir sehen diese Tendenzen auch in Deutschland, aber sie sind bei uns noch wesentlich weniger weit entwickelt.

In den USA begann die Abspaltung alternativ-tribaler Institutionen bereits mit den lokalen Talkradios, die sich nach rechts immer mehr radikalisierten. Rush Limbaugh, Sean Hannity und Glenn Beck waren die frühen Provokateure dieser wachsenden Szene. Seit Mitte der 90er kaufte der neue TV-Sender Fox News einige der „angry white men“ ein und machte sich daran, rechte Radikalrhetorik in den Mainstream zu tragen und wurde so zum medialen Ankerpunkt der Tea-Party-Bewegung.36 Doch noch während des Vorwahlkampfes wurde Fox News rechts von einem neuen Player überholt: der Website Breitbart News, die sich schon früh auf Donald Trump festlegte und die rechte Basis neu definierte – und vor allem auf ein neues Hauptthema einschwor: Migration.

Es verwundert deswegen nicht, dass sich diese Spaltung in den Medien anhand von Social-Media-Daten nachzeichnen lässt. In einer vielbeachteten Studie der Harvard Universität werteten Wissenschaftler/innen um Yochai Benkler 1,25 Millionen Nachrichten aus, die von insgesamt 25.000 Quellen während der Zeit des US-Wahlkampfs (vom 1. April 2015 bis zum Urnengang) auf Twitter und Facebook geteilt wurden.37

Erklärung: Die Größe der Knoten entspricht, wie häufig die Inhalte der Twitter-Accounts geteilt wurden. Der Ort der Knoten zueinander zeigt, wie oft sie von denselben Leuten zur selben Zeit geteilt wurden. Die Farben geben an, ob sie oft von Leuten geteilt werden, die entweder Clinton (blau) oder Trump (rot), oder beide/keinen (grün) retweeten.

Auch wenn die Metriken durchaus anders als in unserem Beispiel funktionieren, sind ihre Aussagen erstaunlich vergleichbar. Vernetzungsdichte und Polarisierung bilden sich in der Harvard-Studie genauso deutlich ab, wie in unserer Auswertung, wenn auch etwas anders. In der vorliegenden Polarisierung finden wir ebenfalls dieselbe, deutliche Asymmetrie: Fast alle traditionellen Medien befinden sich auf der linken, blauen Seite, während sich in Rot kaum ein Medium findet, das älter als 20 Jahre ist. Die meisten und wichtigsten sind sogar jünger als 10 Jahre.

Die Autor/innen der Studie folgern aus dieser Asymmetrie – ähnlich wie wir –, dass die Spaltung keine technische Ursache haben kann. Wäre sie technisch, hätten sich auf der linken wie auf der rechten Seite neue, polarisierende Medien herausgebildet. Und sie würden links eine genauso große Rolle spielen, wie zum Beispiel Breitbart News auf der rechten Seite.

Es gibt aber auch einen deutlichen Unterschied zu unseren Ergebnissen: Die rechte Seite ist trotz ihrer relativen Neuheit und Radikalität den traditionellen Medien auf der – in der Grafik und nicht notwendigenfalls politischen – linken Seite durchaus ebenbürtig. Es handelt sich also nicht um eine Polarisierung zwischen extrem links und extrem rechts, sondern zwischen moderat links und extrem rechts.

Da die linke Seite der Verteilung im Grunde das abbildet, was bislang das Bild der Öffentlichkeit repräsentierte – die traditionellen Massenmedien im Zentrum von den sie umschwärmenden kleineren Medien, wie Blogs und erfolgreiche Twitter-Accounts – ist es vielleicht falsch von einer Spaltung und Polarisierung im Ganzen zu sprechen. Vielmehr sollte man von einer „Abspaltung“ sprechen, denn hier entsteht etwas Neues in Abgrenzung zu etwas Altem. Die rechten Medien und ihre Öffentlichkeiten haben sich jenseits der etablierten Öffentlichkeit gebildet, um sich in Opposition zu ihr zu setzen. Sie haben sich abgespalten, nicht weil das Internet oder die Filterblasen das so bewirkt haben, sondern weil sie es so wollten.

Die Autor/innen der Studie kommen wie wir zu dem Schluss, dass diese Abspaltung folglich kulturelle und/oder ideologische Gründe haben muss. Sie analysieren die Themen der Rechten und zeigen auf, dass ihr Nachrichtenschwerpunkt auf Migration lag, aber auch auf der vermeintlichen Korruptheit von Hillary Clinton und das sie unterstützende Mediensystem, „the liberal Media“. Auch auch hier gilt: Fake News und politisch irreführende Nachrichten gehören zur Normalität und zu den meistverbreiteten Nachrichten dieser Abspaltung.

Es ist Vorsicht geboten, die beiden Analysen allzu eng zu vergleichen, dafür ist die politische und die Medienlandschaft in Deutschland und in den USA zu unterschiedlich. Dennoch drängt sich der Verdacht auf, dass wir es hier mit strukturgleichen Phänomenen zu tun haben.

Die Ähnlichkeiten der US-Abspaltung mit unserem rechten Stamm im Überblick:

- Abspaltung von der etablierten Öffentlichkeit

- Traditionelle Massenmedien verbleiben dabei auf der „anderen“ Seite.

- Themenschwerpunkt Migration und die eigene Opferinszenierung.

- Verstärkte Anfälligkeit für Fake News

- Neuheit der Medien-Kanäle

Wir können also vermuten, dass unsere fakenewsverbreitenden Twitter-Accounts Teil einer ähnlichen Abspaltung sind, wie wir sie in der Harvard-Studie noch deutlicher sehen können. Mehr noch: Man könnte an dieser Stelle spekulieren, dass die USA dieselben Abspaltungsprozesse lediglich früher durchgemacht haben und dass der Befund der Studie quasi dasselbe Phänomen wie unsere Beobachtungen zeigt, nur in einem späteren Stadium. Aus einem Stamm kann eine Parallelgesellschaft entstehen, mit eigenen Medien, eigenen Institutionen und nicht zuletzt: einer eigenen Wahrheit.

Das, was wir in den USA gesehen haben, wäre die Machtübernahme eines zur Parallelgesellschaft ausgewachsenen Super-Stammes. Es ist auszuschließen, dass die kleine Blase, die wir gefunden haben, bei der Bundestagswahl eine vergleichbare Wirkung hatte. Es ist aber nicht auszuschließen, dass der Stamm weiter wächst und gedeiht und irgendwann ähnlich disruptiv in Erscheinung tritt wie sein amerikanisches Pendant.

Dafür muss er aber eigene Strukturen entwickeln, die über die individuelle Vernetzungsstruktur einzelner Twitter-Accounts hinausgehen. In Ansätzen ist das bereits beobachtbar. Blogs wie Political Incorrect, Achgut und Tichys Einblick und vor allem die vielen erfolgreichen, rechten Facebook-Pages und -Gruppen können als „Tribale Institutionen“ gelesen werden. Sie verfügen noch lange nicht über die Reichweite und oft auch nicht über dieselbe Radikalität wie ihre amerikanischen Pendants, aber das kann eine Frage der Zeit sein.

Fazit

Der Traum der freien Vernetzung war ein naiver. Nimmt man alle vergesellschaftenden Zwänge weg, treten unsere prädispositiven Sozialisationsmuster nur umso deutlicher hervor. Menschen haben einen fest verdrahteten Hang, Gruppen zu bilden, sich zu identifizieren, sich abzugrenzen. Ja, wir sind freier in unserer Sozialisation denn je, aber das führt eben nicht zu mehr Individualismus, sondern paradoxerweise in vielen Fällen zu einer stärkeren Gruppenaffinität. Der Stammes-Trieb kann sich nur umso freier entfalten und kommt umso unbändiger zum Tragen. Und je länger ich darüber nachdenke, frage ich mich, ob die fremdbestimmten Kategorien und vorgegebenen Gruppenstrukturen der modernen Gesellschaft nicht auch eine friedensstiftende Zähmung des allzu menschlichen Tribalismus sind. Oder waren. Das Internet ist noch lange nicht fertig mit der Dekonstruktion der modernen Gesellschaft.38

Über die neue Rechte haben wir viel Neues erfahren. Sie ist nicht einfach eine Seite im politischen Kontinuum, sondern eine Abspaltung, das Abspreizen eines neuen Raums jenseits des herkömmlichen politischen Kontinuums. Das Internet ist nicht schuld an dieser Abspaltung, macht sie aber möglich und damit wahrscheinlich. Befreit von den Zwängen und Normalisierungsdynamiken des herkömmlichen Kontinuums, lassen sich „politisch inkorrekte“ Parallelrealitäten schaffen, die sich nicht mehr nur an die gesellschaftlichen Konventionen, sondern gar nicht mehr am Anspruch der Faktizität orientieren müssen.

Jonathan Haidt schreibt in „The Righteous Mind“, dass der Mensch nur ein einziges Argument braucht, um einen Glauben oder einen Nichtglauben zu rechtfertigen. Wenn ich etwas glauben muss (aber nicht will), reicht ein Gegenargument aus, tausend Argumente zu verwerfen. 99 von 100 Klimawissenschaftler sagen, der Klimawandel ist real? Der eine, der was anderes sagt, reicht mir, um die 99 anderen Meinungen zu verwerfen. Oder ich will etwas glauben, wogegen alle Fakten sprechen. Selbst wenn alle meine Einwände gegen die offizielle Version von 9/11 entkräftet werden – ein Argument findet sich immer, um den Glauben beizubehalten, dass es sich um einen „inside job“ handelte.

Das eine Argument ist der Grund, warum der rechte Stamm immun gegenüber den Richtigstellungen seiner Fake News ist, obwohl sie ihn erreichen. Es bleibt immer ein Argument über, um an seinem Narrativ – und somit an seinem Stamm – festzuhalten. Genau dafür wurde das Wort „Lügenpresse“ erfunden. Es impliziert mitnichten die komplette Ablehnung von allem, was die Massenmedien schreiben, sondern ist die Rechtfertigung dafür, der Presse nur das zu glauben, was in das eigene Weltbild passt und den Rest abzutun.39

Ließe man sich auf die tribalistische Sichtweise auf die Medienlandschaft ein (eure Medien vs. unsere Medien), dann würden die klassischen Massenmedien mit ihrer Selbstverpflichtung zu Wahrheit, Ausgewogenheit und Neutralität immer etwa zur Hälfte auf das Konto der Rechten einzahlen, während die rechten Medien ausschließlich auf ihr eigenes Konto buchen. An Überparteilichkeit glauben und danach zu handeln wird so zum entscheidenden strategischen Nachteil der traditionellen Massenmedien.

Die Rechte wird hier mit Sicherheit kontern, dass die tribalistischen Affekte und Strukturen, derer sie in diesem Text bezichtigt werden, doch auf die Linke ebenso zutreffen. Dafür gibt es aber keine Indizien. Eine Gleichsetzung der von uns beobachteten Gruppen jedenfalls verbietet sich aufgrund der deutlichen Datenlage. Das bedeutet allerdings nicht, dass es nicht vielleicht tribalistische Affekte auf der linken Seite gibt, oder sie sich als Reaktion auf die Rechte noch bilden. Auch links gibt es Glaubenssysteme, die stark identitätsstiftend wirken, und wenn Dan Kahan mit seiner Theorie der „Identity Protective Cognition“ recht hat, sollten sich auch auf der linken Seite mit den richtigen Themen ähnliche Effekte beobachten lassen.

Dieser Essay ist kein richtiger Forschungsbericht, sondern kann nur der Startpunkt einer Forschung sein. Es sind noch sehr viele Fragen unbeantwortet und auch einige von uns gemachte Annahmen sind noch nicht hinreichend belegt. Klar ist aber, dass wir hier auf etwas gestoßen sind, das zum einen eine hohe Aussagekraft für die momentane politische Situation in Deutschland hat. Zum anderen sagt es aber – das ist meine Einschätzung – auch etwas Grundlegendes über Politik und Gesellschaft im Zeitalter der digitalen Vernetzung aus.

Jede Politik wird – so es um polarisierende Themen geht – zur Identitätspolitik. Und Identitätspolitik ist hoch motivierend, kompromisslos und wenig bis gar nicht faktenorientiert.

Ein paar offene Forschungsfragen, die der Beantwortung harren:

- Können wir wirklich beweisen, dass der permanent auftauchende rechte Stamm strukturidentisch (und zumindest größtenteils accountidentisch) mit allen von uns aufgezeigten Erscheinungen ist? Wir haben gute Hinweise dafür, aber der Beweis steht noch aus. Es müsste die gesamte Gruppe durchmessen werden und dann gezeigt werden, dass die Fake-News-Accounts Teil dieser Gesamtgruppe sind.

- Wir haben in unseren Untersuchungen zwei spezielle Gruppen miteinander verglichen: rechte Fake-News-Verbreiter und diejenigen, die die Richtigstellungen zu Fake News verbreiten. Die Unterschiede sind wunderbar eindeutig, aber der Vergleich problematisch: Die Richtigsteller sind ebenfalls eine selbstselektierte Gruppe, also nicht repräsentativ. Zudem sind die Gruppen auch noch unterschiedlich groß. Aussagekräftiger wäre also der Vergleich der Fake-News-Gruppe mit einer randomisierten Vergleichsgruppe gleicher Größe.

- Facebook. Facebook ist in der deutschen politischen Debatte der wesentlich einflussreichere Player als Twitter. Können wir also dasselbe oder ähnliche Phänomene auf Facebook finden? Ich würde davon ausgehen, aber bewiesen ist das noch nicht.

- Um den Begriff „digitaler Stamm“ zu rechtfertigen, sollten weitere Stämme gefunden und erforscht werden. Es braucht dafür eine digitale Ethnologie. Gibt es im deutschen Sprachraum weitere Stämme, mit anderen Agenden, Ideologien oder Narrativen, die aber eine ähnliche Abspaltung und Radikalisierung zeigen? Einige Kandidaten wären die digitale Männerechtsbewegung, Sifftwitter und verschiedene Gruppen von Verschwörungstheoretikern. Dann: Wie unterscheiden sich digitale Stämme? Welche Typen von Stämmen lassen sich sinnvoll unterscheiden, etc.? Oder ist Tribalismus mehr eine Achse, auf der man verschiedene Gruppen verorten kann; gibt es verschiedene „Grade“ des Tribalismus und welche Metriken wären dafür sinnvoll?

Es gibt bereits einige Bemühungen zu einer digitalen Ethnologie, doch habe ich das Gefühl, dass ein interdisziplinärer Ansatz vonnöten ist, wenn es um digitale Stämme geht. Datenanalysten, Netzwerkforscher, Psychologen, Soziologen, Ethnologen und Programmierer – vielleicht sogar Linguisten – müssten zusammenarbeiten, um dem Phänomen auf den Grund zu gehen.

Ein andere, weniger wissenschaftliche Frage, ist die, wo das alles endet. Ist der digitale Tribalismus ein nachhaltiger Trend und wird er – wie in den USA geschehen – die Institutionen der modernen Gesellschaft weiterhin unter Druck setzen, sie vielleicht auf lange Sicht sogar zerstören?

Und dringend darauf aufbauend: Was können wir dagegen tun?

Kann man gegen die tribalistischen Reflexe aufklären? Kann man vor ihnen warnen, sie sogar sozial ächten? Oder müssen wir mit ihnen leben und neue Wege finden, sie friedlich zu kanalisieren?

Jonathan Haidt hat zwei Antworten für uns parat. Er vergleicht unsere moralische Entscheidungsmaschinerie mit einem Elefanten und seinem Reiter, wobei der Elefant intuitiv tut, wonach ihm gerade ist, und der Reiter immer nur nachträglich verrationalisiert und rechtfertigt, wo der Elefant nun schon wieder hingegangen ist. Eine erfolgreiche Strategie der Überzeugung besteht also nicht darin, den Reiter mit klugen Argumenten zu konfrontieren, sondern dafür zu sorgen, dass der Elefant einem wohlgesonnen ist. Zum Beispiel durch das Herstellen von persönlichen Vertrauensverhältnissen, um dann mit einer nichtkonfrontativen Argumentationsweise Wege aus der Identitätsfalle zu weisen.

Eine andere Antwort, die Haidt gibt, ist tatsächlich die Kraft der Institution. Institutionen setzen im besten Falle verschiedene Menschen und ihr Weltbild in Konkurrenz zueinander, so dass die verminderte Urteilskraft des Einzelnen ausgeglichen wird. Die Wissenschaft sei zum Beispiel so organisiert, dass einzelne Mitglieder die Erkenntnisse anderer Mitglieder herausfordern sollen. Solange sich immer jemand findet, der die eigene Sicht auf die Welt herausfordert, kann die Gefahr eingegrenzt werden, in der eigenen Fehlwahrnehmung stecken zu bleiben.

Jedoch verweist unsere Entdeckung des digitalen Tribalismus doch genau auf die Auflösung solcher „Checks & Balances“ und auf die Umarmung des unherausgeforderten Stammesdenkens. Tendenziell habe ich eher den Eindruck, dass die Erosion dieser Lösungsstrategie genau das Problem ist, mit dem wir heute kämpfen.

Einen Vorschlag zum persönlichen Umgang mit dem Phänomen hat, ohne sich tatsächlich auf die Forschung zu beziehen, Paul Graham gemacht. In einem kurzen Essay von 2009 mit dem Titel „Keep Your Identity Small“ rät er genau das: sich nicht allzusehr mit Themen und Debatten und Seiten in diesen Debatten zu identifizieren.40 Je weniger Labels man sich anhefte, desto weniger Identitätspolitiken würde man erlauben, das eigene Urteil zu trüben.

Allerdings ist auch dieser Ratschlag nur schwer zu generalisieren, denn es gibt durchaus legitime Identitätspolitiken. Identitätspolitik ist immer dann berechtigt und sogar notwendig, wenn sie gegen das Denken der Mehrheitsgesellschaft durchgesetzt werden muss, weil die Mehrheit die Ansprüche von Minderheiten nicht mitdenkt. Beispiele sind die Rechte von Homosexuellen oder Transsexuellen oder die Probleme, die durch institutionellen Rassismus entstehen. In diesen Fällen haben die Betroffenen schlicht nicht den Luxus, sich mit den Problemen nicht identifizieren zu können.

Eine gesellschaftliche Lösung des Problems müsste wohl wieder Vertrauen in übertribale/überparteiliche Institutionen herstellen und es ist fraglich, ob das mit den alten Institutionen überhaupt noch funktionieren kann. Letztlich war das Vertrauen in diese immer eine fragile Angelegenheit und wahrscheinlich wäre es schon viel eher zerbrochen, wenn es dazu Gelegenheiten gegeben hätte. Die Gelegenheit kam in Deutschland erst mit dem Internet, das es erlaubt, kostengünstig alternative Medienstrukturen zu etablieren. Neue Institutionen, die die Gesellschaft als Ganzes wieder in einen gemeinsamen Diskursrahmen einhegen sollen, müssten der neuen Agilität von Kommunikation unter den digitalen Bedingungen Rechnung tragen, sie sogar für sich zu nutzen wissen.

Eine Art auf den Tribalismus von Rechts zu reagieren, wäre natürlich, selbst tribalistischer zu werden. Eine ausgeprägte „Wir gegen Die“-Polarisierung war immer auch Teil des wichtigen antifaschistischen Kampfes und letztlich notwendiger Teil der politischen Folklore. Ich habe aber den Verdacht, dass die bloße Beschäftigung mit dem rechten, digitalen Stamm dazu führen kann, dass die Gegenseite – also große Teile der Restgesellschaft – sich unwillkürlich tribalisiert. Das heißt ebenso Kohäsion und Identifikation aus der Ablehnung des „Feindes“ zu ziehen. Damit würde die Gesellschaft dem rechten Stamm allerdings einen großen Gefallen tun, denn dann hätte sich seine Verschwörungstheorie (alle stecken unter einer Decke) in eine selbsterfüllende Prophezeihung verwandelt.

Das Problem des digitalen Tribalismus wird uns vermutlich erstmal nicht verlassen. Er wird weiterhin unsere Debatten transformieren und als Resultat auch unsere politischen Landschaften.

Fußnoten:

- Oder wenigstens wie es – etwas weniger naiv – Felix Stalder als „vernetzten Individualismus“ in Aussicht gestellt hat, wonach „… Menschen in westlichen Gesellschaften (…) ihre Identität immer weniger über die Familie, den Arbeitsplatz oder andere stabile Kollektive definieren, sondern zunehmend über ihre persönlichen sozialen Netzwerke, also über die gemeinschaftlichen Formationen, in denen sie als Einzelne aktiv sind und in denen sie als singuläre Personen wahrgenommen werden.“ Stalder, Felix: Kultur der Digitalität, S.144. ↩

- Roberts, David: Donald Trump and the rise of tribal epistemology, https://www.vox.com/policy-and-politics/2017/3/22/14762030/donald-trump-tribal-epistemology (2017). ↩

- Wir haben Twitter für unsere Analyse ausgewählt, weil es durch sein vergleichsweise offenes Format gut automatisiert auswertbar ist. Uns ist bewusst, dass Facebook gerade in Deutschland und gerade auch in rechten Kreise relevanter ist. Wir gehen aber davon aus, dass sich dort dieselben Phänomene abspielen, sodass sich die Erkenntnisse aus der Twitteranalyse auch auf Facebook übertragen lassen. ↩

- Auswärtiges Amt: Schweden: Reise- und Sicherheitshinweise, http://www.auswaertiges-amt.de/sid_39E6971E3FA86BB25CA25DE698189AFB/DE/Laenderinformationen/00-SiHi/Nodes/SchwedenSicherheit_node.html (2017). ↩

- Zu einer näheren Beschäftigung mit dem Begriff der Fake News siehe: Seemann, Michael: Das Regime der demokratischen Wahrheit II – Die Deregulierung des Wahrheitsmarktes. http://www.ctrl-verlust.net/das-regime-der-demokratischen-wahrheit-teil-ii-die-deregulierung-des-wahrheitsmarktes/ (2017). ↩

- Das Projekt Hoaxmap verfolgt diese rechten Gerüchte und Fake News seit einiger Zeit: http://hoaxmap.org/. ↩

- Vgl. Pariser, Eli: The Filter Bubble – How the New Personalized Web Is Changing What We Read and How We Think (2011). ↩

- Die Datenbasis dieses Beispiels ist allerdings in mehrerer Hinsicht problematisch.

1. Der Originalartikel der BILD-Zeitung ist gelöscht. Ebenso der @BILD_de-Tweet dazu und somit alle seine Retweets. Welche Artikel und Bezugnahmen es noch gab, die mittlerweile gelöscht sind, lässt sich nicht mehr rekonstruieren.

2. Einige der Artikel sind über die Zeit geändert worden. Der Artikel von Spiegel Online war zum Beispiel am Anfang sehr viel reißerischer und wäre von uns vermutlich in der Anfangsphase als klare Fake News kategorisiert worden. Irgendwann, als sich herausstellte, dass es immer mehr Ungereimtheiten gibt, muss er abgeschwächt und relativiert worden sein. Wir wissen nicht mit welchen Artikeln das sonst noch so passiert ist. ↩ - Dazu passend hat Eli Pariser, der Erfinder der Filterbubble erst kürzlich in einem Interview zu der Situation in den USA gesagt: “The filter bubble explains a lot about how liberals didn’t see Trump coming, but not very much about how he won the election.” https://backchannel.com/eli-pariser-predicted-the-future-now-he-cant-escape-it-f230e8299906 2017. Das Problem ist also auch laut Pariser eher, dass die linken die Rechten aus dem Blick verlieren, nicht andersrum. ↩

- Vgl. Festinger, Leon: A Theory of Cognitive Dissonance, (1957). ↩

- Ein spezieller Wortschatz (oder Slang) zeichnet wohl auch einen digitalen Stamm aus. Relative Worthäufigkeiten wurden auch andersrum bereits dazu benutzt, homogene Gruppen in sozialen Netzwerken ausfindig zu machen. Vgl. Studie: Bryden, John / Sebastian Funk / AA Jansen, Vincent: Word usage mirrors community structure in the online social network Twitter, https://epjdatascience.springeropen.com/articles/10.1140/epjds15 (2012). ↩

- Nach Haidt, Jonathan: The Righteous Mind – Why Good People Are Divided by Politics and Religion, S. 115 ↩

- Damit war auch immer die These des Homo Oeconomicus aus der Wirtschaftswissenschaft gut begründbar. ↩

- In diesem Zusammenhang sind auch die Forschungen von John Miller und Simon Dedeo interessant. Sie entwickelten eine evolutionär-spieltheoretische Computersimulation, in der Agenten ein Gedächtnis mitbringen, um das Verhalten anderer Agenten in der Vergangenheit in ihre Entscheidungsfindung einzubeziehen. Wissen konnte außerdem unter Generationen von Agenten vererbt werden. Es stellte sich heraus, dass die Agenten anfingen, wiederkehrende Muster in dem Verhalten anderer Agenten zu sehen und ihr Vertrauen auf die Homogenität dieser Muster zu verlagern. Diese „Stämme“ mit homogenen Verhaltensmustern kooperierten vollständig und waren schnell die erfolgreichsten Populationen. Setzten sich aber über viele Generationen durch Mutationen geringe Verhaltensänderungen durch, kam es zu einer Art Genozid. Ganze Populationen wurden ausgelöscht und eine Phase von Instabilität und Misstrauen folgte. Tribalismus scheint eine evolutionäre Strategie zu sein. Vgl. Dedeo, Simon: Is Tribalism a Natural Malfunction? http://nautil.us/issue/52/the-hive/is-tribalism-a-natural-malfunction (2017). ↩

- Die These der Gruppenselektion (oder„Multi-Level-Selection“) ist bereits von Darwin ins Spiel gebracht worden, ist aber unter Biologen umstritten. Jonathan Haidt führt gute Argumente ins Feld, warum sie vor allem aus psychologischer Sicht, sehr viel Sinn ergibt. Vgl. Haidt, Jonathan: The Righteous Mind – Why Good People Are Divided by Politics and Religion, 210 ff. ↩

- Vgl. auch Greene, Joshua: Moral Tribes – Emotion, Reason, and the Gap Between Us and Them (2013), S. 63. ↩

- Maffesoli, Michel: The Time of the Tribes – The Decline of Individualism in Mass Society (1993). ↩

- Quinn, Daniel: Beyond Civilization – Humanity’s Next Great Adventure. (1999) ↩

- NEOTRIBES http://www.neotribes.co/en ↩

- Godin, Seth: Tribes – We Need You to Lead Us (2008). ↩

- „Lügenpresse“ kommt zum Beispiel in unserer Auswertung der Tweets der Fake-News-Verbreiter 226-mal vor, bei dem Rest 149. „Altparteien“ kommt sogar auf 235 vs. 24. ↩

- “We’ve tried to do similar things to liberals. It just has never worked, it never takes off. You’ll get debunked within the first two comments and then the whole thing just kind of fizzles out.” Das sagt Jestin Coler gegenüber NPR. Er ist professioneller Fake-News-Entrepreneur, der während des US-Wahlkampfes viel Geld mit dem Streuen von Unwahrheiten verdient hat. Sein Zielpublikum seien die Trump-Anhänger, Liberale seien nicht so leicht zu ködern. Sydell, Laura: We Tracked Down A Fake-News Creator In The Suburbs. Here’s What We Learned. http://www.npr.org/sections/alltechconsidered/2016/11/23/503146770/npr-finds-the-head-of-a-covert-fake-news-operation-in-the-suburbs (2016). ↩

- Der Unterschied zu Fake News liegt vor allem darin, dass es sich hier nicht um Behauptungen wider besseren Wissens handelte, sondern um Mutmaßungen, die meistens auch als solche Erkennbar waren. Aber der Untersuchung zu liebe tun wir einfach so, als wären falsche Mutmaßungen dasselbe wie Fake News. ↩

- Die Ausrichtung der Grafik orientiert sich am Schwerpunkt der Fake-News-Verteilung. ↩

- Unklar bleibt hingegen, ob sich mit linken Fake News zu anderen Themen ein digitaler Stamm nachweisen ließe. Große Verbreitung in linken Kreisen finden zum Beispiel falsche Zitate oder Bildmontagen zu Donald Trump. Solche Beispiele sind aber vor allem im englischen Sprachraum aufgefallen und es würde methodisch schwierig werden, hier ein sauberes Forschungsdesign für die deutsche Twittersphäre hinzubekommen. Ein interessantes, zu untersuchendes Beispiel im deutschen Wahlkampf wäre die Fake News (die wohl aber als satirischer Hoax gemeint war), Alexander Gauland hätte sich relativierend über Hitler geäußert. Vgl. Schmehl, Karsten: DIE PARTEI legt AfD-Spitzenkandidat Gauland dieses Hitler-Zitat in den Mund, aber es ist frei erfunden, https://www.buzzfeed.com/karstenschmehl/satire-und-luegen-sind-nicht-das-gleiche?bftwdenews&utm_term=.relgPQzB6#.dgbOgvyQw (2017). ↩

- Es gibt nicht wenige Texte zu der tribalistischen, politischen Situation in den USA, in der Autor/innen auch bestimmten linken Kreisen tribalistische Tendenzen unterstellen. Vgl. Sullivan, Andrew: America Wasn’t Built for Humans. http://nymag.com/daily/intelligencer/2017/09/can-democracy-survive-tribalism.html (2017) und Alexander, Scott: I Can Tolarate Anything Except The Outgroup, http://slatestarcodex.com/2014/09/30/i-can-tolerate-anything-except-the-outgroup/ (2014). ↩

- Dafür spricht auch, dass bereits bei anderen Ereignissen, ähnliche Phänomene nachweisbar waren. Siehe zum Beispiel die Tweetauswertungen zum Amoklauf von München letztes Jahr. Vgl. Gerret von Nordheim: Poppers Alptraum, http://de.ejo-online.eu/digitales/poppers-alptraum (2016). ↩

- Ein Kandidat für einen Stamm, zu dem es bereits Untersuchungen gibt, ist „Sifftwitter“. Luca Hammer hat sich die Netzwerkstrukturen dieser Gruppe angesehen und seine Ergebnisse scheinen zumindest anschlussfähig an unsere Untersuchungen. Vgl. Walter, René: Sifftwitter – Mit den Trollen ums Datenfeuer tanzen. http://www.nerdcore.de/2017/05/09/sifftwitter-mit-den-trollen-ums-datenfeuer-tanzen/ (2017). ↩

- Cultural Cognition Project (Yale Law School): http://www.culturalcognition.net/. ↩

- Kahan, Dan M.: Motivated Numeracy and Enlightened Self-Government, https://papers.ssrn.com/sol3/papers.cfm?abstract_id=2319992 (2013). ↩

- Kahan, Dan M: Misconceptions, Misinformation, and the Logic of Identity-Protective Cognition. https://papers.ssrn.com/sol3/papers.cfm?abstract_id=2973067 (2017). ↩

- Was wiederum den Studien recht gibt, die Fake News in den USA vor allem als kommerzielles Phänomen einordnen. Vgl. z.B. Allcott/Gentzkow: Social Media and Fake News in the 2016 Election, https://www.aeaweb.org/articles?id=10.1257/jep.31.2.211 (2017). ↩

- Roberts, David: Donald Trump and the Rise of Tribal Epistemology, https://www.vox.com/policy-and-politics/2017/3/22/14762030/donald-trump-tribal-epistemology (2017). ↩

- Seemann, Michael: Die Globale Klasse – Eine andere Welt ist möglich, aber als Drohung. http://mspr0.de/?p=4696 (2016). ↩

- Diesen Bias zu reflektieren hat neulich Richard Gutjahr aufgerufen. Dass die Medienschaffenden tatsächlich eine Filterblase gegen rechte Gedankengebäude haben, ist in unseren Daten nachgewiesen. Vgl. Gutjahr, Richard: Von Fake News, Filterblasen und digitaler Empathie, http://www.gutjahr.biz/2017/05/filterblase/ (2007). ↩

- Tatsächlich verweist bereits Seth Godin in seinem 2008er Buch „Tribes“ auf das Beispiel Fox News. Fox News habe es geschafft, sich einen Stamm zu erschaffen. Vgl. God, Seth: Tribes – We need you to lead us, 2008, S. 48. ↩

- Berkman Center: Partisanship, Propaganda, and Disinformation: Online Media and the 2016 U.S. Presidential Election, https://cyber.harvard.edu/publications/2017/08/mediacloud (2017). ↩

- In diesem Zusammenhang sind auch die teilweise fürchterlichen Ereignisse zu deuten, die in Entwicklungs- und Schwellenländern die Einführung des Internets in breite Bevölkerungsschichten flankieren. Zum Zusammenhang der antimuslimischen Ressentiments in Burma mit Fake News und der wahnsinnig schnellen Popularisierung des Internet siehe zum Beispiel Frenkel, Sheera: This Is What Happens When Millions Of People Suddenly Get The Internet https://www.buzzfeed.com/sheerafrenkel/fake-news-spreads-trump-around-the-world?utm_term=.ldeLYlXJ8#.eyamPokbX (2017) und wie Gerüchte im Internet zu einem Genozid im Süd-Sudan führen könnten: Patinkin, Jason: How To Use Facebook And Fake News To Get People To Murder Each Other, https://www.buzzfeed.com/jasonpatinkin/how-to-get-people-to-murder-each-other-through-fake-news-and?utm_term=.fbDeo8pv0#.xe4EvW2xb (2017). ↩

- Vgl. Lobo, Sascha: Die Filterblase sind wir selbst, http://www.spiegel.de/netzwelt/web/facebook-und-die-filterblase-kolumne-von-sascha-lobo-a-1145866.html, (2017). ↩

- Graham, Paul: Keep Your Identity Small, http://www.paulgraham.com/identity.html (2009). ↩

Pingback: Linkdump #58 | WZB Data Science Blog

Pingback: Links der Woche – Enno Park

Pingback: Wo ist die Energie hin? | Innocent Glow

Pingback: Die kommunikativen Hausaufgaben für uns alle nach der Bundestagswahl

Pingback: Digitaler Tribalismus und Fake News » dokmz

Pingback: Algorithmenethik | Wie algorithmisch sortierte Intermediäre wirken - Algorithmenethik

Pingback: ruff linkage 201743

Pingback: Digital Tribalism – The Real Story About Fake News | ctrl+verlust

Pingback: Zu Fake-News und neotribaler Kommunikation im Internet – TrIBES

Pingback: Digitaler Tribalismus – Das hässliche Making Of | H I E R

Pingback: Kommunikationsmodell Populismus? – Wissenschaftskommunikation.de

Pingback: ruff linkage 201743 – Pieceoplastic

Pingback: Resonanz schlägt Logik (?) – Tribale Epistemologien – Shock and Awe

Pingback: Der Turmbau zu Bubble. – über.lesen | über.schreiben

Pingback: Warum die AfD wirksame Klimapolitik ablehnt – Erklärungsansätze « Pure Coincidence

Pingback: „From Sankt. Pauli with LOVE“ – der St. Pauli Podcast live vom Kiez › St. Pauli Nu*de

Pingback: Ist die digitale Gesellschaft noch zu retten? Ein Gastbeitrag von Michael Seemann – Wikimedia Deutschland Blog

Pingback: Die letzten 10 Jahre | H I E R

Pingback: Digitaler Faschismus und politische Polarisierung in den USA - PRIF BLOG

Pingback: Digitaler Tribalismus - Filterblase - Echokammer

Pingback: Krasse Links No 10. | H I E R

Pingback: Krasse Links No 19. | H I E R